Anthropic stelde de release van Claude 4.5 uit, maar de geruchtenmachine draait op volle toeren. In deze blog neem ik je mee langs de meest recente hints, voorspellingen en speculaties – en reflecteer ik op wat deze volgende stap kan betekenen voor developers, bedrijven én ons eigen Mind-platform.

Nog even geduld… maar wat als?

Claude 4.5 belooft meer redeneerkracht en een monster-context, maar blijft voorlopig in de coulissen.

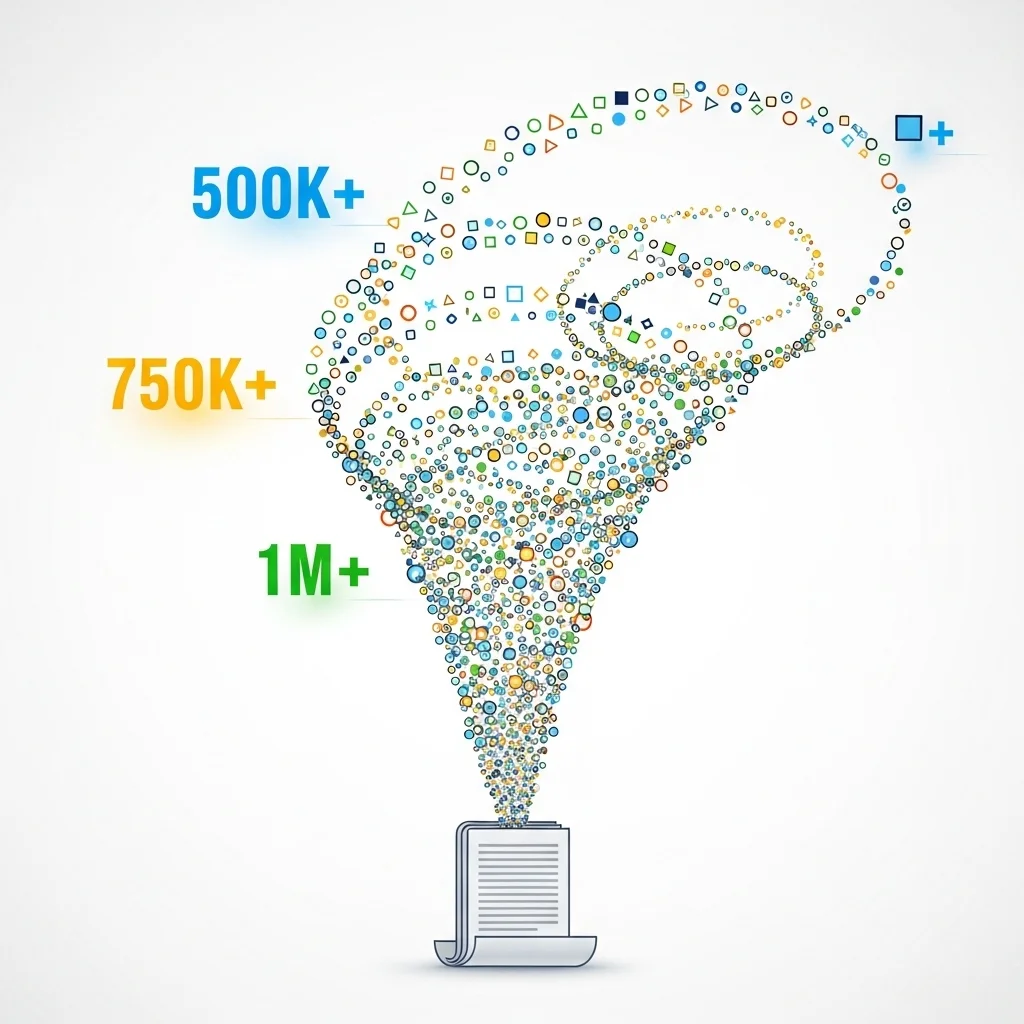

Extreem lange context (500k+ tokens)

Verbeterde redenering en keten-van-gedachten

Multimodale input (beeld + spraak)

Native "memory" voor team-workflows

Betere code-generatie én uitleg

Veiligheids-upgrades om jailbreaks te voorkomen

Actiepunten uit deze blog:

Hoe je je prompt-strategieën nu al kunt voorbereiden

Waar dit in de TALL-stack raakt aan Livewire-componenten

Waarom een model-agnostisch platform (zoals Mind) je snelle switch garandeert

Drie kernvragen vóór je integreert

Context-explosie

Anthropic test naar verluidt contextwindows boven de 500.000 tokens. Denk aan volledige code-bases of due-diligence-dossiers in één prompt. Maar: latency en kostprijs blijven de grote mitsen.

Redeneerkracht

Interne benchmarks lekten dat 4.5 tot 15 % beter scoort op Big-Bench-Hard dan 4.1. In de praktijk vertaalt dat zich naar minder hallucinatierisico bij complexe ketens van vragen – goud voor compliance-chatbots.

Multimodaal + Memory

Er circuleren screenshots van een "Memory"-toggle in een interne Claude-build. Combineer dat met image-input en je krijgt een AI-collega die ontwerpen, diagrammen én voortgang onthoudt tussen sessies.

Zo bereiden wij ons voor

Stap 1 – Testprompt her-design

Wat wij doen is bestaande Opus- en Sonnet-prompts refactoren naar chunk-formaat van ±20k tokens, zodat opschalen naar 4.5 straks plug-and-play is.

Stap 2 – Dataveiligheid op orde

Onze aanpak hierbij: sandbox-omgeving + synth-data om nieuwe modeluitvoer te valideren zonder klant-PII te riskeren.

Stap 3 – Latency-budget monitoren

Pro-tip: meet nu al responstijden bij 200k-tokens-prompts (Gemini 2.5 of Grok 4 Fast) en definieer een acceptabel SLA-window.

Stap 4 – Mind-switch ready

Met Mind koppelen we modellen via één driver-interface. We schrijven nu aparte adapters voor verwachte Claude-4.5-API-wijzigingen (o.a. memory flags).

Stap 5 – Stakeholder demo-scripts

Let hier vooral op: richt demoscenario's in die nieuw 4.5-voordeel tastbaar tonen – bijv. end-to-end code-review of full-document summarization.

Benieuwd hoe jij jouw roadmap kunt klaarmaken voor Claude 4.5 of wil je gewoon sparren over AI-switch-strategieën? Laat van je horen in de comments – ik hoor graag je ideeën en uitdagingen!

Claude 4.5 in vogelvlucht

De geruchtenbron

Laatst struikelde ik over een reeks social-posts waarin developers claimen "een stealth-model met 4.5-capaciteit" te hebben gezien. Wat mij opvalt in de praktijk: dit soort lekken zit zelden ver van de waarheid. Een Substack-nieuwsbrief van deze week vat de consensus samen: het gaat om een tussengeneratie, geen volledige Claude 5, met focus op redeneerkracht en context.

Uitstel = finetunen op veiligheid

Opvallend is dat Anthropic het uitstel vooral koppelt aan safety-checks. Gezien de recente zero-click prompt-inject-issues bij concurrerende modellen begrijp ik dat. Enterprises vragen om robuuste guardrails voordat ze gevoelige data toevertrouwen.

Vergelijking met de concurrentie

GPT-5-o-testbuilds mikken op reasoning + tool-usage

Gemini 2.5 Flash excelleert in prijs-per-1k-tokens

Grok 4 Fast stunt met 2M-context én lage latency

Als 4.5 die elementen combineert – dus lange context, goede prijs-performance én sterkere veiligheid – dan staat er een serieuze challenger klaar.

Waarom context er écht toe doet

Van code-review tot due diligence

Uit onze ervaring blijkt dat projectteams vaak struikelen over contextlimieten. Een Laravel-monoliet van 150k regels past nu eenmaal niet in 200k tokens als je er ook instructies bij stopt. Kunnen we straks 500k tokens voeren, dan wordt "explain-the-whole-repository" ineens realistisch.

Impact op TALL-stack-development

Stel je voor dat een Livewire-component automatisch door Claude eventuele performance-bottlenecks aanwijst door de volledige PHP- en Blade-optreeping te analyseren. Met grotere context ontstaat de kans dat de AI verbanden ziet tussen backend, front-end en database-queries in één keer.

Kosten-perspectief

Natuurlijk: meer tokens betekent meer geld. Bij GPT-4-o zie ik prijzen die exponentieel oplopen boven de 100k tokens. Als 4.5 dat goedkoper weet te leveren – Anthropic hint op efficiënter sparsity-routing – dan kan dit het commerciële verschil maken.

Multimodaal + Memory: hype of game-changer?

Memory voor teams

Recent zien we dat LLM-vendors experimenteren met sessie-geheugen dat per work-space wordt gedeeld. Het interessante is dat Anthropic volgens screenshots een toggle toevoegt waarmee admins memory kunnen in- of uitschakelen. Dit zou compliance-teams geruststellen maar dev-teams alsnog historie laten opbouwen.

Beeld & spraak in één API

Onze klantcases tonen dat gebruikers verwachten een foto te uploaden, mondeling feedback te geven en direct een samenvatting te krijgen. Als 4.5 native multimodaliteit levert, kunnen we in Mind één unified flow behouden i.p.v. losse calls naar vision- of speech-endpoints.

Voorbeeld uit de praktijk

Een interessante ontwikkeling die ik zie: in een experiment met Gemini 2.5 lieten we een bouwtekening uploaden en realtime stuklijst berekenen. Stel dat 4.5 dit combineert met nóg sterkere reasoning, dan kunnen we meteen validatie op bouwvoorschriften laten uitvoeren.

Wanneer wordt Claude 4.5 nu verwacht?

Niemand buiten Anthropic weet de definitieve datum. Social-kanalen suggereren "binnen enkele weken", maar de release is al twee keer opgeschoven vanwege extra safety-tests.

Hoeveel kost 4.5 vergeleken met Opus 4.1?

Officiële prijzen ontbreken. Geruchten spreken over ~25 % hogere prijs per 1k tokens, maar met drastisch grotere context waardoor de 'cost-per-insight' juist kan dalen.

Zal 4.5 hogere latency hebben door de grotere context?

Uit onze ervaring met vergelijkbare modellen is er altijd extra verwerkingstijd. Anthropic test echter een nieuwe router-architectuur zodat alleen relevante tokens actief worden doorgerekend – latency zou vergelijkbaar moeten blijven.

Kunnen bestaande Claude-API-integraties blijven werken?

Ja, maar reken op nieuwe parameters (memory, vision-mode). Wij bouwen in Mind daarom adapters met feature-flags, zodat ontwikkelaars simpel kunnen togglen.

Is multimodaliteit veilig voor privacy-gevoelige beelden?

Uit onze ervaring met medische data geldt: zorg voor on-premise pre-anonymisatie of versleutelde upload. Wacht op officiële Anthropic-richtlijnen voor GDPR-compliance.

Hoe verhoudt 4.5 zich tot open-source Llama 4?

Llama 4 is sterk in fine-tuning, maar mist de schaal en safety-training van Anthropic. Voor enterprise-kritieke processen verwachten wij dat 4.5 de voorkeur krijgt, tenzij datapsovereiniteit zwaarder weegt.

Gaat 4.5 onze dev-jobs overnemen?

Uit onze ervaring: het neemt boilerplate weg, maar creatief probleemoplossen en architectuurkeuzes blijven mensenwerk. Denk aan co-piloting, niet replace-piloting.

Kan ik nu al profiteren zonder op 4.5 te wachten?

Absoluut. Optimaliseer prompts, experimenteer met 200k-modellen en bouw een model-agnostische architectuur. Dan switch je straks zonder refactor-hoofdpijn.