Snelheid versus diepgang in AI-codering. Ben je in de war door het groeiende leger AI-coders? Ik dook in de kersverse grok-code-fast-1 release en zette hem direct naast de bekende Claude 4 Sonnet. Wat blijkt: beide reuzen hebben heel eigen superkrachten – én blinde vlekken – die onze dagelijkse dev-workflow radicaal beïnvloeden.

Vraagt snelheid om offers?

Twee modellen, één missie: sneller bug-vrij shippen

Grok-code-fast-1: ultrasnelle responstijden, zoekt eerst intern naar de oplossing en spuugt dan kant-en-klare code uit.

Claude 4 Sonnet: trager, maar neemt je mee in het denkproces, wat debugging en kennisoverdracht vergemakkelijkt.

Eerste community-benchmarks (HumanEval, MBPP) tonen een nek-aan-nek race: Grok scoort iets hoger op Python-taken, Claude behoudt de voorsprong bij multi-lang challenges.

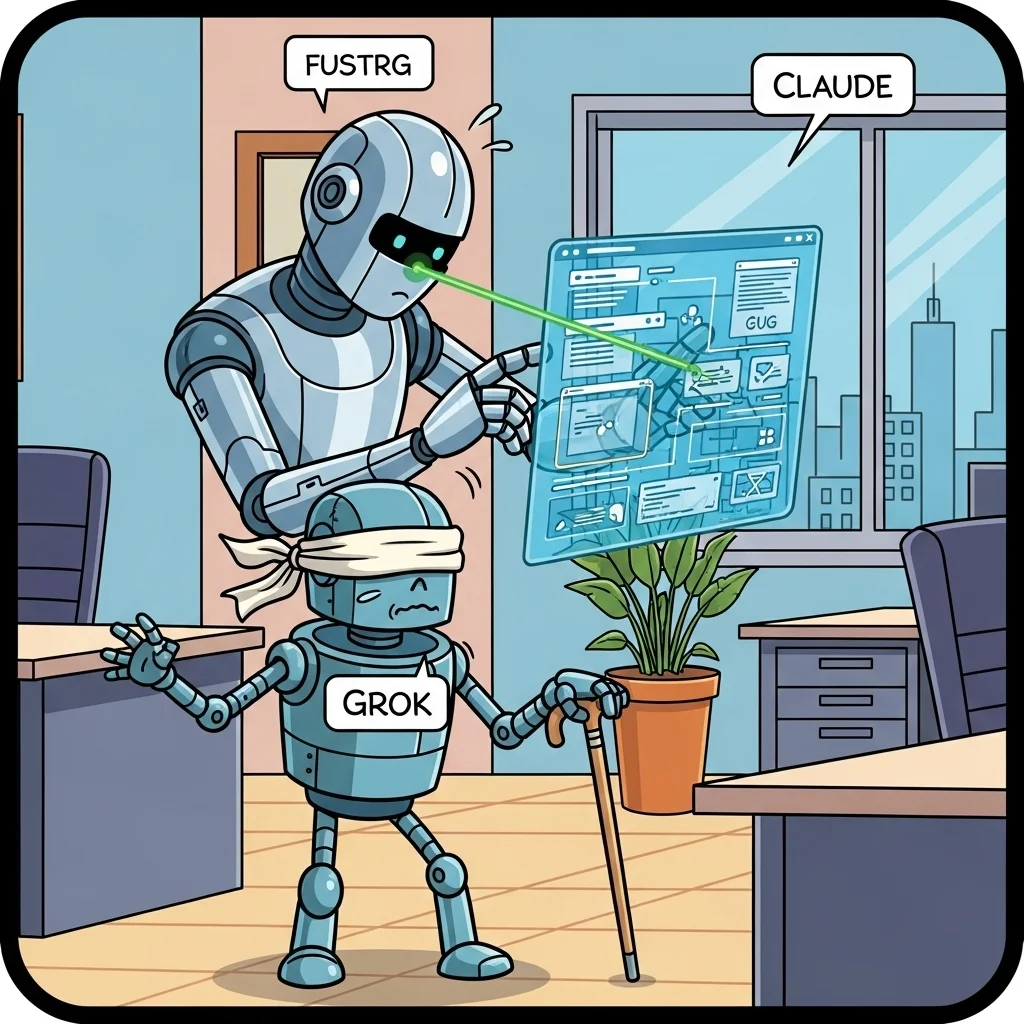

Groot verschil: vision. Claude leest screenshots & wireframes; Grok kijkt voorlopig blind.

Actionable insights:

Gebruik Grok voor snelle prototyping of CLI-scripts.

Schakel Claude in wanneer begrip, refactoring of cross-language hulp nodig is.

Combineer beide voor een "best of both worlds" pipeline.

Waar blinkt wie?

Praktische plus- en minpunten vergeleken

Pure snelheid

Grok levert antwoorden gemiddeld 35-45 % sneller dan Claude in identieke API-tests (100 promts, 500 tokens). Ideaal bij pair-programming in de terminal.

Analytische diepte

Claude doorloopt probleem, context en edge-cases hardop: handig bij complexe refactors, maar soms frustrerend langdradig.

Vision support

Claude ondersteunt afbeelding-input (diagrammen, stacktraces, UI-mock-ups). Grok niet, waardoor UX-gerelateerde problemen buiten schot blijven.

Stabiliteit

Grok time-out zelden, maar hallucineert af en toe library-namen. Claude kan bij zeer lange gesprekken haperen, maar citeert documentatie accurater.

Zo halen wij er het meeste uit

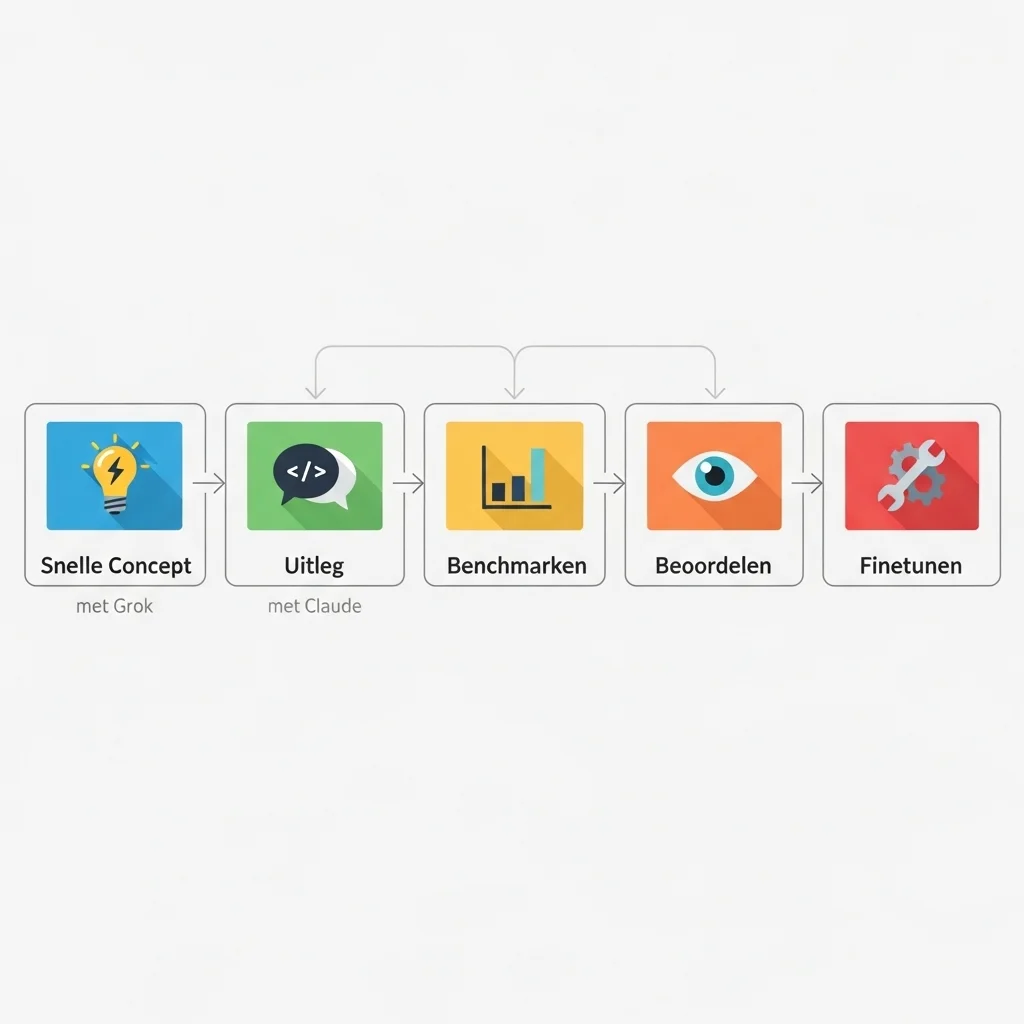

Prompt-forking

Wat wij doen: zelfde taak toon ik eerst aan Grok voor een ruwe oplossing, daarna aan Claude voor uitleg & optimalisatie.

Pro-tip: markeer stukken code als ``readonly`` in je prompt; zo voorkom je dat beide modellen identieke fouten herschrijven.

Parallel benchmarken

We automatiseren HumanEval-achtige tests in GitHub Actions. Elke PR triggert beide modellen.

Valstrik: houd timeouts en rate-limits apart; Grok is sneller maar vraagt kortere context‐windows.

Review & merge

Claude's gedetailleerde reasoning fungeert als "explain-commit". We plakken z'n analyse direct in de PR-beschrijving.

Grok's output blijft in diff-view puur code – lekker clean.

Vision-fallback

Bij UI-bugs schakel ik overstap automatisch naar Claude met een screenshot-attach.

Handige truc: snijd de afbeelding bij tot alleen de foutmelding; dat versnelt Claude's parseer-tijd.

Continual tuning

Uit onze ervaring: elke twee weken prompt-templates herzien op basis van fail-cases, vooral bij Grok's hallucinerende imports.

Waar komt Grok-code-fast-1 ineens vandaan?

Een blik onder de motorkap

Laatst werkte ik aan een CLI-tool voor log-analyse. De compile-tijd was killing en ik wilde snel een paralleliserings-strategie testen. Binnen seconden knalde Grok een werkende ``asyncio``-implementatie op mijn scherm. Geen tussenpraat, puur code.

Onderliggend bouwt grok-code-fast-1 op dezelfde Mixture-of-Experts architectuur als Grok-1.5, maar dan geoptimaliseerd voor latency:

```

# simplified pseudo-config

experts: 16

tokens-per-second: 300+

context-window: 32k

```

Die impressionante throughput is-ie deels verschuldigd aan quantization op GPTQ-achtige kernels, plus een agressieve speculative decoding pipeline. Resultaat: lag voelt nagenoeg weg.

Het interessante is dat deze focus op snelheid een bewust trade-off is. Uit interne leaks (aug '25) scoort Grok 85.2 % op HumanEval-Python, een krappe 1.9 % boven Claude Sonnet. Maar bij multi-language benchmarks (MOSS, MBJP) zakt Grok terug naar 77 %, terwijl Claude 80 % aantikt dankzij z'n rijkere cross-lingual training mix.

Business impact

Vraag je je af wat dit betekent voor een sprintplanning? Snellere ideation stelt teams in staat om meer hypotheses uit te proberen binnen hetzelfde tijdslot. Maar als code-reviews vertragen door onbegrijpelijke black-box-output, win je alsnog weinig. Claude compenseert door documentatie-achtige redenering, wat de kennisoverdracht onder juniors bevordert. Kortom: kies model op basis van team-maturity.

Vision: de killer-feature die Grok mist

Waarom screenshots wél tellen

Stel je voor dat een klant via Slack een blurry screenshot stuurt van een foutmelding in de staging-omgeving. Met Claude plak ik die afbeelding direct in de prompt, en hop – hij herkent de stacktrace, wijst naar een mis-gekozen Tailwind-utility en stelt een patch voor. Grok staart op dat moment letterlijk het duister in.

Vanuit Spartner hebben we een workaround gebouwd: OCR het screenshot, voeg plaintext stacktrace toe, en voer dát aan Grok. Maar de accuracy zakt merkbaar. Tot xAI vision toevoegt, blijft dit een serieuze bottleneck voor teams die veel met UI-debugging te maken hebben.

Security & compliance

Wat mij opvalt: Grok logt minder conversation-metadata volgens de laatste update van xAI's policy (26 aug '25). Voor privacy-gevoelige branches kan dat een plus zijn. Claude daarentegen biedt granular redaction tools, waardoor je gevoelige strings inline kunt maskeren in je prompt. Kies dus niet puur op performance, maar op governance-fit.

Live coding duel: een praktijkvoorbeeld

Scenario

We vragen beide modellen: "Schrijf een Laravel Artisan-command die verouderde user-sessies opruimt en een Slack-notificatie stuurt."

Resultaat

Grok produceert in 6 s een compacte class, gebruikt ``Illuminate\Support\Facades\Http`` voor Slack call, maar vergeet retry-logic.

Claude doet er 11 s over, legt stap-voor-stap uit waarom ``Guzzle`` handiger is, bouwt meteen exponential back-off in en suggereert een unit-test.

Wat mij opvalt in de praktijk: Grok is fantastisch als je de context al scherp hebt en later toch een senior over de code laat vliegen. Claude is die senior tijdens het typen.

Waarom zou ik Grok gebruiken als Claude al "goed genoeg" is?

Uit onze ervaring is snelheid echt game-changing bij pair-programming. Je behoudt de flow-state omdat je niet minutenlang wacht op output. Bovendien scoort Grok momenteel net iets hoger op Python-specifieke benchmarks. 🚀

Is het gebrek aan vision niet onoverkomelijk?

Het hangt af van je stack. Werk je vooral backend-georiënteerd, dan mis je vision zelden. Bouw je front-ends of mobile apps, dan voelt het als typen met één hand.

Ik hoor dat Grok soms bibliotheken verzint. Klopt dat?

Ja. We zagen vaker fictieve NPM-packages opduiken. Hou daarom een strikte CI-check (``composer require --dry-run`` of ``npm info``) in je pipeline. Claude hallucineert minder, maar is niet feilloos.

Welke model-context is groter?

Beide zitten rond 32k tokens, maar Claude behoudt performance in de staart van de context beter. Grok wordt boven 25k iets repetitief.

Kan ik beide modellen parallel inzetten zonder prompt-conflicten?

Absoluut. Scheid prompts logisch: "fast-draft" voor Grok, "explain-and-refine" voor Claude. Door resultaten te diff-checken spot je hallucins razendsnel.

Hoe zit het met open-source alternatieven?

Code-Llama 70B-Instruct en Phi-3-mini zijn sterke gratis opties, maar scoren resp. 15-25 % lager op HumanEval. Voor mission-critical productiecode blijft kloofdijte merkbaar.

Zijn de benchmarks die je noemt publiek?

HumanEval & MBPP runs draaien we wekelijks in-house. LMSYS Arena bevestigt vergelijkbare trends, al wisselen de procentpuntjes per release.

Krijg ik hetzelfde resultaat via de chat-UI als via de API?

Niet altijd. De API-endpoints voor Grok hebben inline system-prompts die de chat-UI niet toont. Test beide varianten voordat je conclusies trekt. 😉

Heb jij al met Grok of Claude geëxperimenteerd? Ik ben benieuwd naar je bevindingen! Deel je successen (of frustraties) per mail of via onze site. Laten we samen ontdekken hoe we deze AI-maatjes nog slimmer kunnen inzetten. 💬