Japanse kuststad moet excuses aanbieden na AI berenalarm, wake-upcall voor publieke veiligheid

Een Japanse kuststad heeft deze week landelijke opschudding veroorzaakt na een officiële waarschuwing over een loslopende beer, gebaseerd op een volledig door generatieve AI gemaakte foto. Het incident dwingt overheden wereldwijd om veel scherper te kijken naar verificatie, protocollen en beveiliging rond AI in meldkamers en crisiscommunicatie.

De waarschuwing werd via officiële kanalen verspreid, met de boodschap dat inwoners binnen moesten blijven vanwege een beer die in de buurt van de kust gesignaleerd zou zijn. Later bleek dat het beeld dat de autoriteiten als bewijs gebruikten, geen foto uit het veld was, maar een volledig door generatieve AI geconstrueerde afbeelding. De stad heeft inmiddels publiekelijk excuses aangeboden.

Wat er precies misging

Volgens Japanse media was het AI beeld in een interne workflow terechtgekomen als illustratief voorbeeld, waarna het per abuis werd geïnterpreteerd als daadwerkelijke bewijslast. De combinatie van tijdsdruk, beperkte verificatie en een gebrek aan duidelijke AI protocollen zorgde ervoor dat de waarschuwing zonder extra controle live ging.

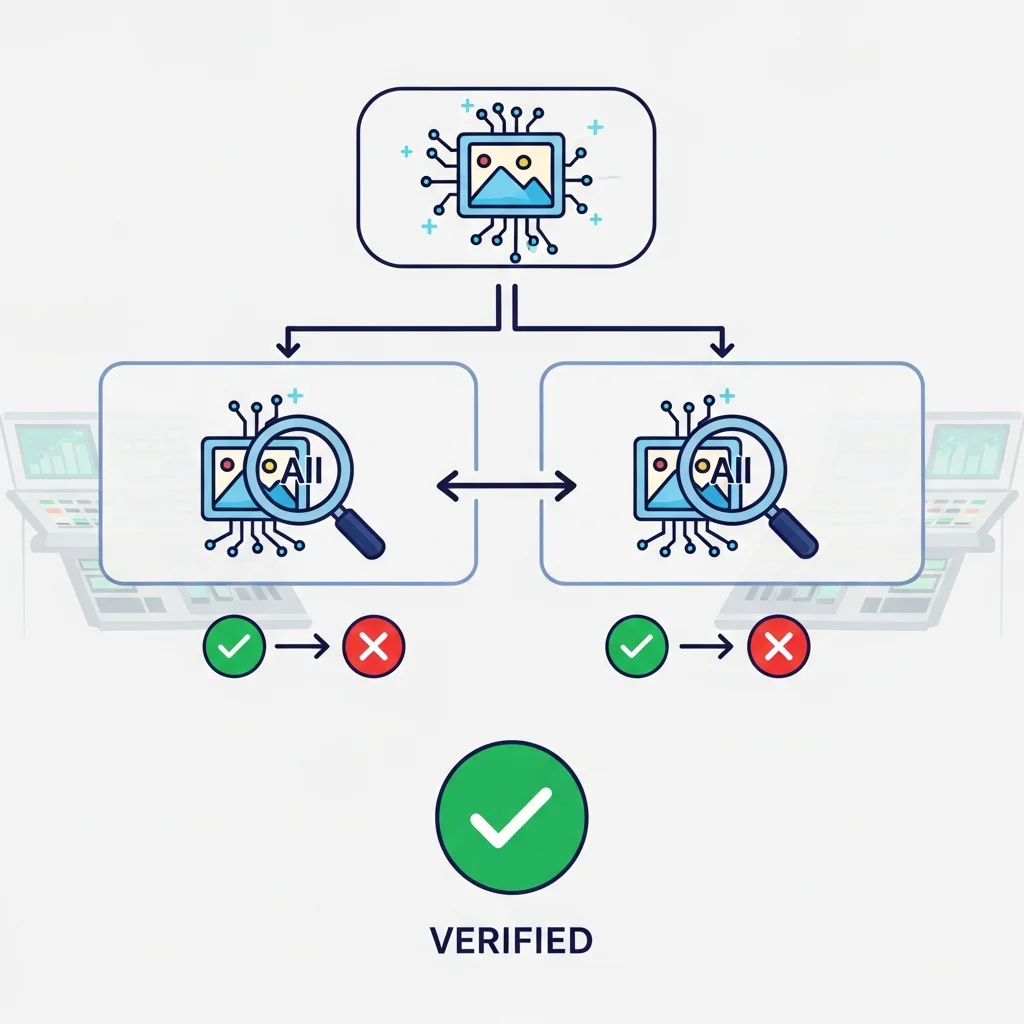

Opvallend is dat er geen aanvullende verificatie op basis van bronmetadata of locatiegegevens is uitgevoerd. Elementen zoals EXIF data, GPS informatie of onafhankelijke bronverificatie werden niet systematisch gecheckt, terwijl dit in moderne meldkamers en veiligheidsketens steeds meer standaard zou moeten zijn bij visuele informatie.

Het incident laat zien hoe kwetsbaar bestaande processen zijn wanneer AI beelden en deepfakes zonder duidelijke markering of checks binnenkomen in overheids- en hulpverleningssystemen.

Lessen voor Europese gemeenten en veiligheidsregio's

Voor Europese gemeenten en veiligheidsregio's is dit voorval een harde reminder dat AI niet alleen kansen, maar ook nieuwe risico's introduceert in de informatiestroom richting burgers.

Gebrek aan AI bronlabeling en traceerbaarheid Veel generatieve beeldsystemen bieden mogelijkheden voor watermerken, provenance metadata of cryptografische handtekeningen, maar in de praktijk worden die vaak niet verplicht of standaard geactiveerd. Zonder duidelijke labeling kan een AI beeld gemakkelijk als authentieke foto in een operationeel systeem belanden.

Onvoldoende tweelagencontrole op visuele informatie Bij veel organisaties geldt een vierogenprincipe voor besluiten, maar niet expliciet voor bewijsbeelden. Visuals worden dan als neutraal of vanzelfsprekend beschouwd, terwijl AI juist op dit vlak de meeste verwarring kan veroorzaken.

Ontbrekende AI bewustwording bij niet technische teams Lokale overheden, politievoorlichting, communicatieafdelingen en meldkamers werken steeds meer met digitale kanalen, maar AI training en bewustwording blijven achter. Medewerkers herkennen deepfake patronen, samenstelling artefacten of inconsistenties in licht en perspectief vaak niet.

In combinatie maakt dit de weg vrij voor fouten zoals in Japan, maar ook voor kwaadwillende actoren die deepfake beelden gebruiken om paniek te zaaien, beleid te beïnvloeden of desinformatiecampagnes te voeren.

Van incident naar beleid: welke protocollen ontbreken nog

Het incident in Japan raakt direct aan actuele discussies over AI governance, zowel in Europa als daarbuiten. Binnen de EU AI Act en aanverwante regelgeving ligt de nadruk op transparantie, risicoclassificatie en menselijk toezicht. Toch zijn veel concrete operationele protocollen op het niveau van gemeenten, veiligheidsregio's en uitvoeringsorganisaties nog niet uitgewerkt.

Belangrijke hiaten zijn onder meer:

Formele richtlijnen voor het gebruik van generatieve beelden in overheidscommunicatie In veel landen zijn er wel regels voor privacy en archivering, maar nauwelijks specifieke regels voor door AI gemaakte beelden, vooral niet bij noodcommunicatie of openbare waarschuwingen.

Standaard AI checklists voor meldkamers en persvoorlichting Denk aan verplichte vragen als: wat is de bron van dit beeld, is er technische verificatie gedaan, is bekend of een AI generator is gebruikt, en zijn er alternatieve bewijzen beschikbaar.

Technische tooling voor automatische detectie en labeling Er zijn steeds meer tools die AI gegenereerde beelden kunnen herkennen op basis van signaturen of typische patronen, maar implementatie bij lokale overheden en hulpdiensten blijft beperkt.

Het Japanse incident zal naar verwachting nieuwe druk zetten op toezichthouders en wetgevers om hier concretere kaders voor te ontwikkelen, zeker nu generatieve AI modellen zich snel verbeteren en steeds realistischer beelden produceren.

Consequenties voor publieke veiligheid en vertrouwen

Een vals alarm over een loslopende beer lijkt misschien relatief onschuldig, maar de implicaties voor publieke veiligheid zijn aanzienlijk. Als burgers vaker worden geconfronteerd met meldingen die later onjuist blijken te zijn, kan het vertrouwen in officiële waarschuwingen snel eroderen.

Bij echte dreiging wordt een waarschuwing mogelijk minder serieus genomen, omdat mensen eerdere fouten herinneren.

Bij twijfelgevallen kan verwarring ontstaan, vooral als sociale media alternatieve beelden of verhalen verspreiden, wat besluitvorming in crisissituaties verder bemoeilijkt.

Bovendien laat het incident zien hoe makkelijk AI systemen een rol kunnen spelen in de veiligheidsketen, zelfs als er geen bewuste keuze is gemaakt om AI in te zetten. Een enkel verkeerd opgeslagen generatief beeld of een losse illustratie in een intern document kan uiteindelijk uitmonden in een publieke waarschuwing met maatschappelijke impact.

Relevantie voor AI ontwikkelaars en aanbieders

Voor ontwikkelaars van generatieve modellen en AI platforms is dit incident opnieuw een signaal dat technische veiligheidsmaatregelen niet optioneel zijn, maar integraal onderdeel van een verantwoord AI ecosysteem.

Content provenance met cryptografische handtekeningen die kunnen aantonen dat een beeld door een AI model is gemaakt, inclusief herleidbare informatie over het model en de gebruikte tool.

Zichtbare en onzichtbare watermerken die ook bij beperkte compressie of bewerking blijven bestaan, zodat AI detectietools deze kunnen herkennen.

Ingebouwde waarschuwingen en disclaimers bij export, vooral wanneer beelden mogelijk in een context met hoge impact worden gebruikt, zoals nieuws, politiek of publieke veiligheid.

Het voorval in Japan zal waarschijnlijk worden aangehaald in discussies tussen toezichthouders, overheden en leveranciers over de vraag in hoeverre dergelijke maatregelen verplicht moeten worden voor modellen die beschikbaar zijn voor brede publieksgroepen.

Europese context: AI, deepfakes en publieke sector

In Europa werken verschillende landen aan richtlijnen voor het gebruik van generatieve AI in de publieke sector. Sommige landen hebben al interne beleidsdocumenten opgesteld die het gebruik van deepfakes en synthetische media in politieke campagnes of officiële communicatie beperken.

Toch ontbreekt vaak een fijnmazige aanpak voor lokale overheden, waar de combinatie van beperkte middelen, hoge werkdruk en snel veranderende technologie extra kwetsbaar maakt. Het geval van de Japanse kuststad biedt een concrete casus om bestaande richtlijnen aan te scherpen.

Te verwachten discussies in de komende periode zijn onder meer:

Moeten alle door overheden gebruikte beelden in noodcommunicatie aantoonbaar authenticiteitschecks doorlopen?

Welke rol krijgen nationale en Europese CERTs en toezichthouders bij het uitrollen van standaard AI verificatie tooling?

In hoeverre worden AI leveranciers verplicht om provenance en detectietools aan te bieden wanneer hun modellen in publieke context worden gebruikt?

Hoewel er op dit moment nog geen uniforme Europese norm is, neemt de druk om tot duidelijke regels te komen met dit soort incidenten zichtbaar toe.

Conclusie

Het valse berenalarm in een Japanse kuststad lijkt op het eerste gezicht een opmerkelijke, bijna anekdotische fout. In werkelijkheid legt het een fundamentele kwetsbaarheid bloot in de manier waarop overheden en publieke organisaties nu omgaan met AI gegenereerde beelden.

Zonder heldere protocollen, technische waarborgen en brede bewustwording bij operationele teams, kunnen generatieve AI systemen, zelfs onbewust, leiden tot misinformatie vanuit officiële bron. Voor beleidsmakers, toezichthouders en AI ontwikkelaars wereldwijd is dit incident daarmee een duidelijke waarschuwing: de integratie van AI in publieke veiligheidsprocessen vraagt om meer dan alleen innovatie, het vereist ook strakke governance, verifieerbare herkomst en robuuste controlemechanismen.