AI agents zijn meer dan slimme chatbots; ze kunnen handelen. Ontdek hoe tool calling werkt, hoe Large Language Models (LLM’s) externe software aansturen en waarom dit de toekomst van automatisering is.

Van praten naar doen

De eerste generatie Generatieve AI (zoals de vroege ChatGPT) was indrukwekkend, maar passief. Je kon vragen om een e-mail te schrijven, maar de AI kon hem niet versturen. Je kon vragen om een data-analyse, maar de AI had geen toegang tot live bedrijfsdata. Dit markeert de fundamentele verschuiving naar AI Agents: software die niet alleen praat, maar ook daadwerkelijk handelt in de echte wereld.

Wat is een AI Agent?

Een AI Agent is een systeem dat een Large Language Model (LLM) gebruikt als "brein" om taken te plannen en uit te voeren. In tegenstelling tot een standaard chatbot, beschikt een agent over:

Doelgerichtheid: Hij werkt zelfstandig naar een specifiek eindresultaat toe (bijv. "Boek een vergaderruimte").

Omgevingsbewustzijn: Hij kan de actuele status van systemen en data uitlezen.

Gereedschap (Tools): Hij kan functies aanroepen via API's om wijzigingen door te voeren.

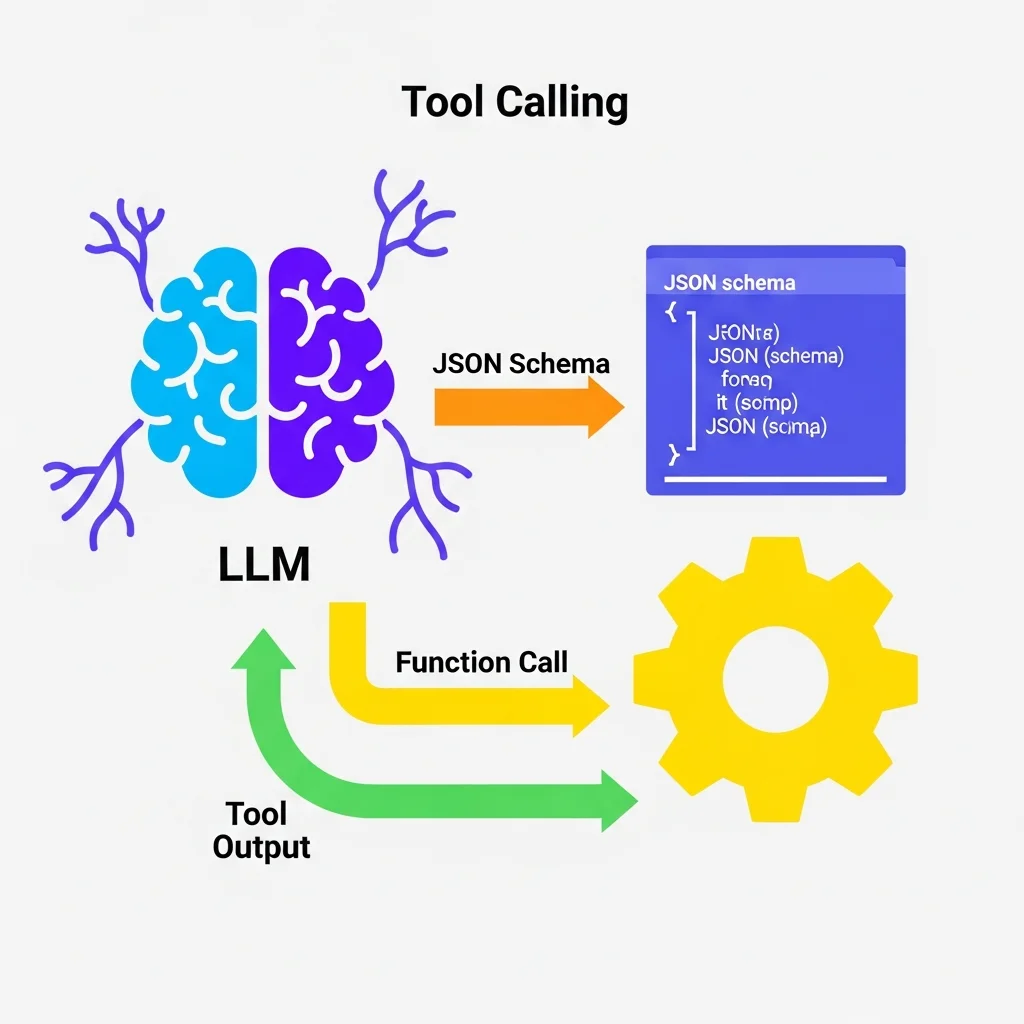

Hoe werkt Tool Calling (Function Calling)?

De kracht van agents ligt in Tool Calling (of Function Calling). Hiermee genereert een LLM geen menselijke tekst, maar gestructureerde code (vaak JSON) om specifieke functies in software aan te sturen.

Het proces in 4 stappen:

Definitie: De ontwikkelaar beschrijft de beschikbare tools aan het model. Bijvoorbeeld: "Hier is een tool `get_weather(city)`".

Intentie: De gebruiker vraagt: "Regent het in Amsterdam?"

Selectie: Het model "denkt na" en besluit dat het de tool `get_weather` nodig heeft. Het genereert de JSON: `{ "tool": "get_weather", "city": "Amsterdam" }`.

Executie: De applicatie voert deze functie uit, haalt de weerdata op en geeft het resultaat terug aan het model. Het model formuleert vervolgens het eindantwoord aan de gebruiker.

Hier is een voorbeeld van hoe zo'n tool-definitie eruitziet in code:

{

"name": "create_support_ticket",

"description": "Maak een nieuw supportticket aan in het CRM",

"parameters": {

"type": "object",

"properties": {

"subject": { "type": "string", "description": "Onderwerp van het probleem" },

"priority": { "type": "string", "enum": ["low", "high"] },

"customer_email": { "type": "string" }

},

"required": ["subject", "customer_email"]

}

}

Architecturen: Single vs. Multi-Agent

Naarmate taken complexer worden, volstaat één enkele agent vaak niet meer. We zien verschillende architecturen ontstaan:

Single-Agent Architectuur

Hierbij is er één centrale "General Purpose" agent die toegang heeft tot alle tools. Dit werkt goed voor lineaire, overzichtelijke taken. Een veelvoorkomend voorbeeld is een klantenservice-bot die zowel bestellingen kan opzoeken als retourzendingen kan verwerken. Het risico is echter dat bij een groeiend aantal tools de agent het overzicht verliest.

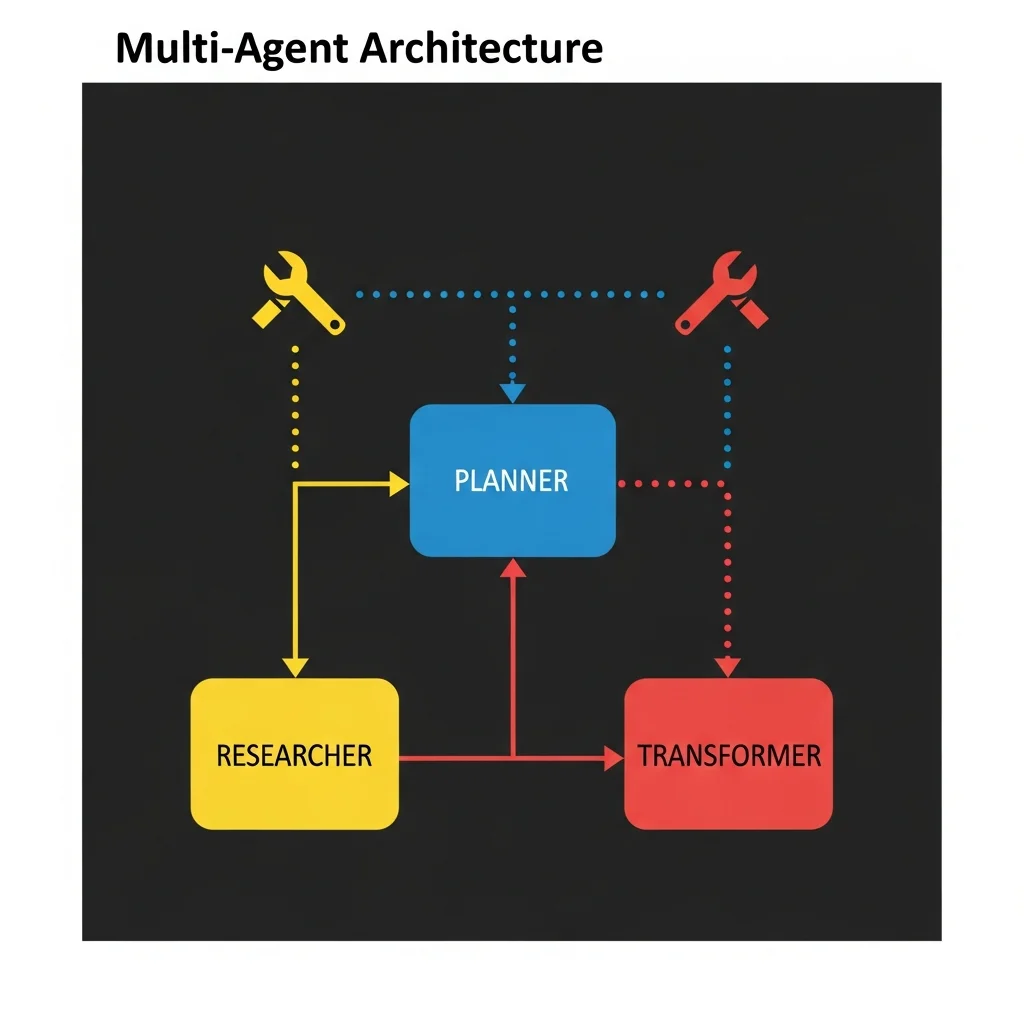

Multi-Agent Systemen (MAS)

In complexe bedrijfsomgevingen werken we met gespecialiseerde agents die samenwerken als een team. Denk hierbij aan:

Een Research Agent die informatie zoekt op het web.

Een Coding Agent die Python-scripts schrijft en uitvoert.

Een Review Agent die het werk van de andere agents controleert.

Een "Orchestrator" (dirigent) stuurt deze agents aan en verdeelt de taken. Dit vermindert fouten en maakt het systeem robuuster en schaalbaarder.

Veiligheid en controle (Guardrails)

Het geven van autonomie aan software brengt risico's met zich mee. Foutief uitgevoerde acties kunnen grote gevolgen hebben. Daarom is "AI Governance" essentieel.

Belangrijke veiligheidsmaatregelen zijn:

Human-in-the-loop: Voor kritieke acties (zoals betalingen of e-mails naar klanten) vraagt de agent eerst expliciete goedkeuring van een mens.

Read-only tools: Beperk de rechten van agents waar mogelijk tot alleen-lezen (alleen kijken, niet wijzigen).

Input/Output validatie: Controleer strikt of de data die de agent naar een API stuurt technisch valide en veilig is.

Video uitleg: Agents in actie

Veelgestelde vragen

Wat is het verschil tussen een agent en een assistent?

Een assistent (zoals Siri of een chatbot) reageert vaak passief op vragen. Een agent is proactief en autonoom: hij kan plannen maken, meerdere stappen uitvoeren en tools gebruiken om een complex doel te bereiken zonder voortdurende menselijke sturing.

Welke programmeertalen worden gebruikt voor AI agents?

Python is de standaardtaal voor AI-ontwikkeling vanwege frameworks zoals LangChain, AutoGen en CrewAI. Echter, met de opkomst van TypeScript-bibliotheken wordt JavaScript/Node.js ook steeds populairder voor het bouwen van agents.

Zijn AI agents veilig voor bedrijfsdata?

Mits goed geïmplementeerd, ja. Het is cruciaal om agents niet direct op productie-databases aan te sluiten zonder tussenlaag, strikte API-toegangsrechten te hanteren en geen gevoelige persoonsgegevens (PII) te delen met externe LLM-providers.

Wat is een "ReAct" patroon?

ReAct staat voor "Reasoning + Acting". Het is een populaire techniek waarbij de agent eerst "hardop denkt" (Reasoning: "Ik moet de prijs opzoeken") en daarna pas de actie uitvoert (Acting: Roept prijs-API aan). Dit verbetert de betrouwbaarheid aanzienlijk.