AI governance waar je

echt grip op krijgt.

AI is al lang geen speeltje van de innovatielab-hoek meer, nou, elke afdeling stuurt tegenwoordig prompts de cloud in. En precies daar wringt het: hoe houd je zicht op risico’s, datastromen en nieuwe regels als de AI Act risk and control framework zich steeds verder uitrolt? Spartner bundelt governance, risk assurance en dagelijkse praktijk in één helder platform zodat IT en business weer ademen durven te halen.

Wat staat er op het spel?

Zonder structuur ontstaat er chaos in data, verantwoordelijkheid en compliance.

Automatiseren

Iedere medewerker verzint z’n eigen prompt, dus stromen ongescreende gegevens naar GPT-achtige modellen. Gevolg: data-lek, reputatieverlies, boze toezichthouders.

Integreren

Een wildgroei aan chatbot-tools creëert stille silo’s terwijl je eigenlijk uniforme kwaliteitsnormen en audittrails nodig hebt.

Innoveren

Als governance strak zit kun je sneller nieuwe AI-features uitrollen, want je hoeft niet telkens het wiel opnieuw juridisch af te tikken.

Borgen

Van risico-classificatie tot logarchivering, een control-bibliotheek maakt naleving van de AI Act risk and control framework aantoonbaar.

Waarom een centrale aanpak werkt

Een sushichef snijdt vis met één mes, niet met tien, omdat consistentie smaak redt. Zo werkt het ook met AI governance: één platform, één waarheid, voorkomt een zure nasmaak bij auditors.

Overigens merken we dat organisaties vaak pas laat beseffen hoeveel afdelingen eigen AI-scripts draaien.

Dat gezegd hebbende, zodra alle requests via één gateway lopen zie je direct patronen, fouten en kansen terugkomen.

Sterker nog, door realtime dashboards kan men security-teams laten ingrijpen voordat de toezichthouder zelfs maar vragen stelt.

Volledig inzicht in prompts en datastromen

Automatische classificatie volgens AI Act-risiconiveaus

Rapportages die auditors snappen zonder technische deep-dive

Koppelingen met bestaande servicedesk en chatbotworkflows

Stap voor stap naar robuuste AI governance.

Volg deze stappen om AI-governance snel én aantoonbaar op orde te krijgen.

Stap 1 — Inventariseren.

We beginnen met een scan van alle huidige AI-touchpoints. Wat ons opvalt is dat bedrijven de helft vergeten, vooral die no-code tools die marketing “even snel” heeft aangezet.

Stap 2 — Classificeren.

Elke use-case landt in een risk assurance matrix: laag, gemiddeld, hoog of prohibited. Dus direct duidelijk welke controles verplicht zijn.

Stap 3 — Inbedden.

Daarna koppelen we Spartner Mind aan je identity-platform. Want een solide governance staat of valt met goede authenticatie en rolbeheer.

Stap 4 — Monitoren & alerteren.

Dashboards tonen wie, wat, wanneer heeft aangevraagd én welke data richting externe LLM’s vloeit. Piekt iets? Dan tikken we automatisch op de digitale vingers.

Stap 5 — Rapporteren.

Maandelijkse rapporten sluiten naadloos aan op het AI Act risk and control framework zodat compliance-teams tijd winnen en auditors een lach krijgen.

Stap 6 — Continu verbeteren.

Regelgeving verandert, medewerkers vinden nieuwe trucs, wij passen policies en modellen aan zonder je dagelijkse werk te verstoren.

De filosofische laag van AI governance

Vrijheid versus verantwoordelijkheid

AI kan creativiteit ontketenen, maar zonder kaders wordt die vrijheid willekeur. Zoals ik eerder al aangaf, governance is het kompas dat richting geeft.

Wie stuurt de machine?

Mensen bouwen modellen, maar modellen beïnvloeden mensen terug. Daarom beschouwen we governance niet als rem, eerder als vangrail op een bochtige bergweg.

Transparantie is geen luxe

Men roept vaak “black box” en haalt de schouders op. Bij Spartner eisen we logica-traces zodat beslissingen uitlegbaar blijven, ook al voelen ze nu nog wat complex.

Concreet aan de slag met controls

Praktische tips die morgen toepasbaar zijn

Zet één proxy-endpoint op voor alle AI-API-calls.

Log volledige prompts én responses, maar pseudonimiseer gevoelige velden.

Koppel risk labels aan gebruikersrollen zodat high-risk requests vooraf review nodig hebben.

Hanteer retentietermijnen; niet elk log moet eeuwig mee.

Laat legal meelezen bij model-updates binnen je chatbot.

Wat we in de praktijk zien:

Veel ondernemingen slaan alleen user-input op, niet het model-antwoord. Terwijl dat antwoord juist risico kan bevatten (bijv. foutief advies).

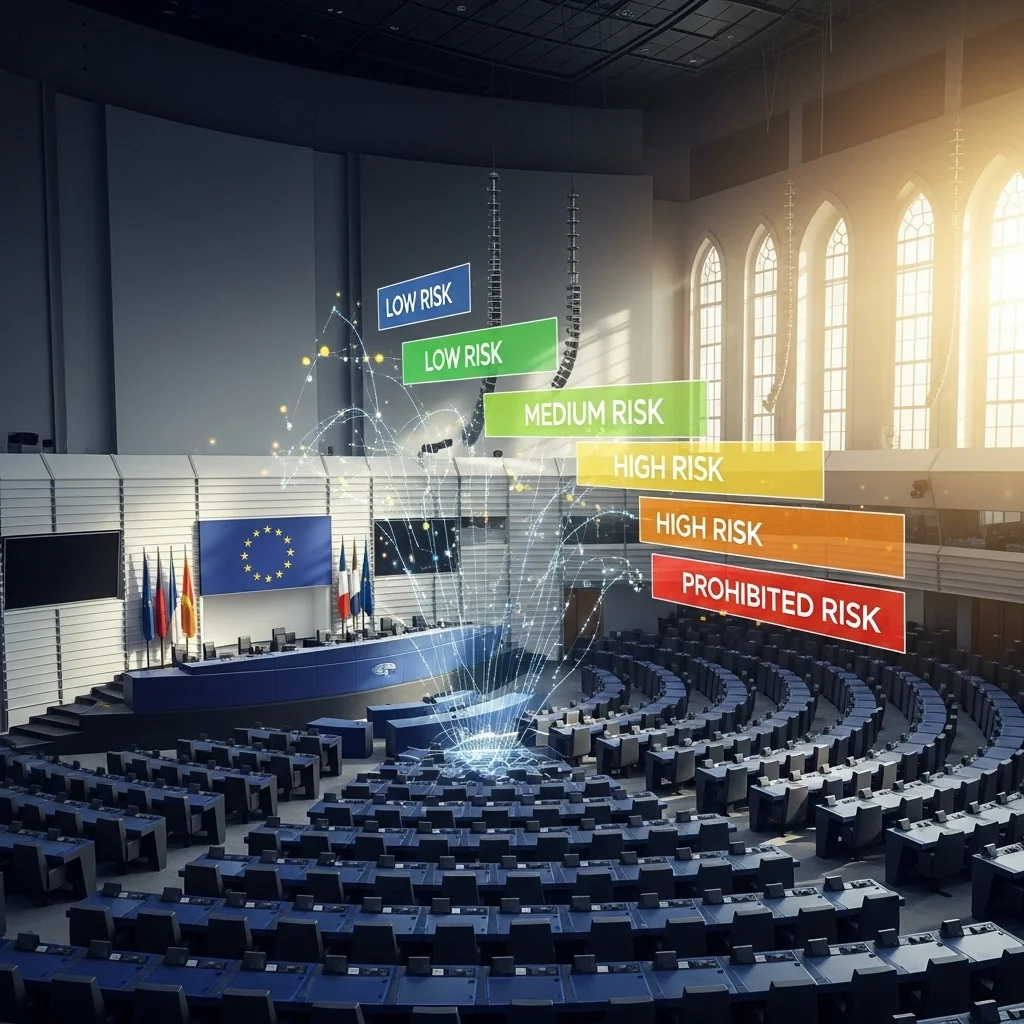

Een kritische blik op de AI Act

Regels in beweging, organisatie ook

De AI Act risk and control framework kent vier risicoklassen. Hoog-risico systemen (denk aan HR-selectie) vereisen rigoureuze governance; generatieve chatbots vallen soms lager maar kunnen alsnog escaleren.

Onzekerheden blijven

Nog niet alle secundaire wetgeving is uit-uitgewerkt, dus bouw governance modulair. Vandaag label X, morgen misschien X+.

Nooit te laat om te beginnen

Wachten op definitieve teksten klinkt logisch, maar dan loop je achter. Door nu al risk assurance processen op te zetten win je later maanden.

Klaar om AI onder controle te krijgen?

Plan een vrijblijvende sessie met onze governance-specialisten en ontdek hoe snel je risks, controls en innovatie op één lijn krijgt. We luisteren, stellen kritische vragen en laten live zien hoe Spartner Mind jouw AI-landschap temt.

Wat is AI governance eigenlijk? 🤔

AI governance is het geheel aan processen, regels en tools waarmee je verantwoord AI ontwikkelt en gebruikt. Denk aan risk assurance, compliance-checks en continue monitoring.

Heb ik een apart team nodig voor governance? 🧐

Niet per se. We zien organisaties succes boeken met een cross-functioneel squad waarin legal, IT en business samen beslissen. Spartner Mind ondersteunt die samenwerking.

Kan ik bestaande chatbots blijven gebruiken? 💬

Ja. Via standaard-API’s koppelen we populaire platforms, zodat je huidige investeringen behouden blijven, terwijl governance-lagen erbovenop komen.

Hoe verhoudt dit zich tot GDPR? 📜

De AI Act vult GDPR aan. Onze tooling borgt beide: privacy-filters én AI-specifieke controles zoals explainability-logs.

Is alles gelijk high-risk onder de AI Act? 😅

Nee hoor. De meeste interne productiviteitsbots vallen lager. Maar zodra beslissingen impact hebben op mensenlevens of rechten, stijgt het risiconiveau.

Wat kost een audit als ik niets regel? 💸

Hoog. Boetes kunnen oplopen tot percentages van wereldwijde omzet. Beter voorkom je dat door tijdig governance in te richten.

Hoe snel kan Spartner Mind live gaan? ⏱️

We blijven vaag over exacte weken, maar door standaard-integraties is een proof-of-value verrassend rap.

Krijgt mijn IT-team extra werk? 🤖

In het begin wel wat afstemming, daarna juist minder brandjes blussen. Automatisering scheelt ad-hoc tickets.

Ondersteunt het platform meerdere LLM vendors? 🌐

Jazeker, we spreken OpenAI, Azure OpenAI, Google Gemini en zelfs on-premise Llama-clusters.

Verwar ik governance niet met innovatieremmers? 🚀

Integendeel. Met duidelijke spelregels durf je sneller te experimenteren, omdat iedereen weet waar de grenzen liggen.

.webp)