AI-agents zijn het gesprek van de dag, maar wat doen ze nu écht? In deze blog ontrafel ik de bouwstenen, vergelijk ik de populairste tools en deel ik hoe wij bij Spartner met ons Mind-platform bedrijven helpen om agenten in recordtijd live te krijgen – zonder te verdwalen in de tooling-jungle.

Vraag jij je ook af hoe "autonome AI-agents" verder gaan dan een simpele chatbot?

De essentie in 3 minuten

Agents beslissen, gebruiken tools en itereren zelfstandig – alsof je er een digitale collega bij krijgt.

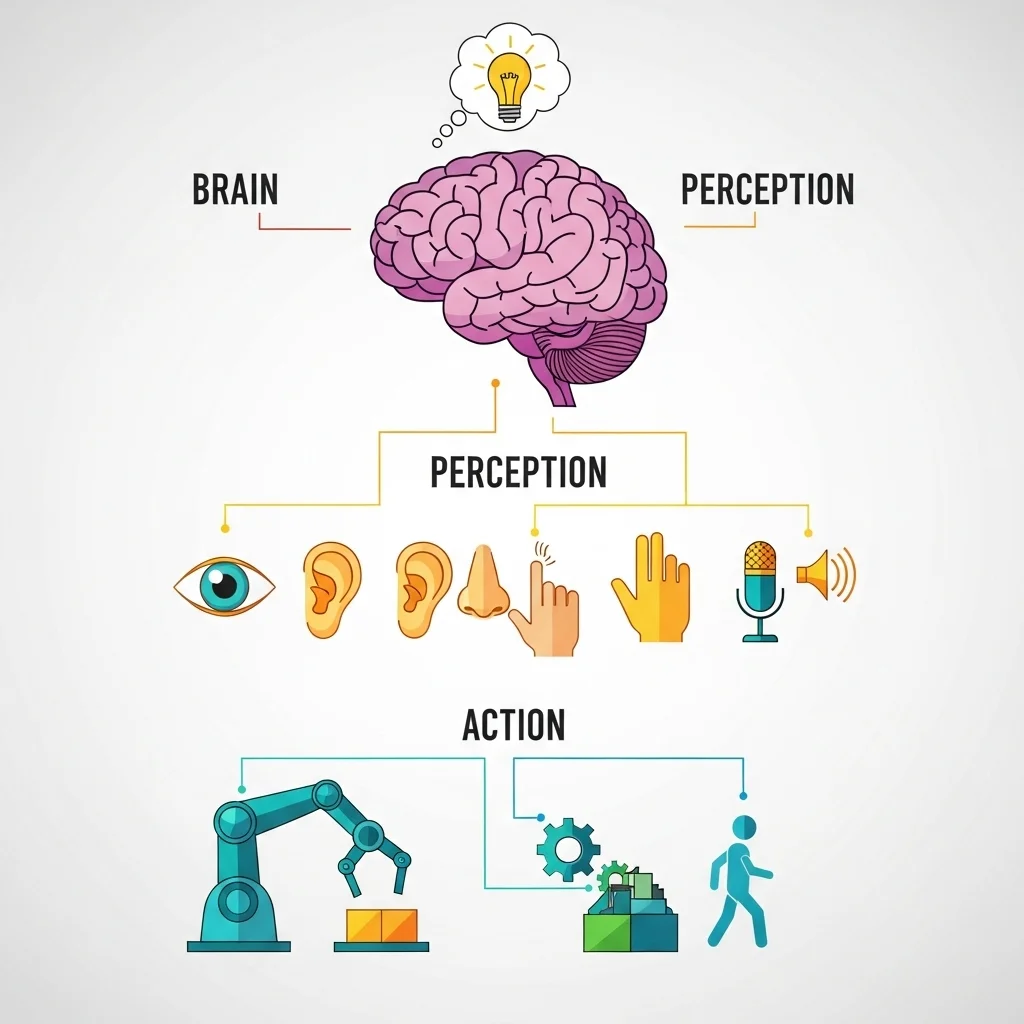

Drie onmisbare lagen: Brain (LLM + logica), Perception (API's / data) en Action (uitvoeren + herhalen).

Open-source frameworks (LangGraph, AutoGen) bieden maximale controle; no-code suites (Vertex AI Agent Builder, Copilot Studio) leveren snelheid.

Spartner koppelt die ecosystemen aan ons eigen Mind-platform: model-agnostisch, razendsnelle integratie en directe aansluiting op je bestaande processen.

Actionable insights:

Start met één scherp gedefinieerde use-case.

Kies tooling op basis van compliance-eisen en data-locatie.

Laat de agent klein beginnen, maar geef 'm wél geheugen en evaluatielussen.

Combineer open-source flexibiliteit met een robuuste orchestrator (bijv. Mind) voor productie.

Agenten bouwen nu

Van praatpaal naar productiviteit

Nieuwe collega

Een agent is géén chatbot: het combineert LLM-redenering met toolgebruik en een feedback-lus. Vergelijk het met een junior developer die zelf tickets oppakt, informatie opzoekt en tussendoor leert.

Drie lagen

Brain – het LLM + je eigen prompt-/rule-engine.

Perception – API-connectors, RAG, sensors.

Action – code-executie, webhooks, of zelfs robots.

Tool-landschap

Open-source: LangGraph, AutoGen, CrewAI, OpenAI Swarm, Camel.

No-code / Enterprise: Vertex Agent Builder, Beam AI, Copilot Studio, Lyzr, Glide.

Spartner-mindset

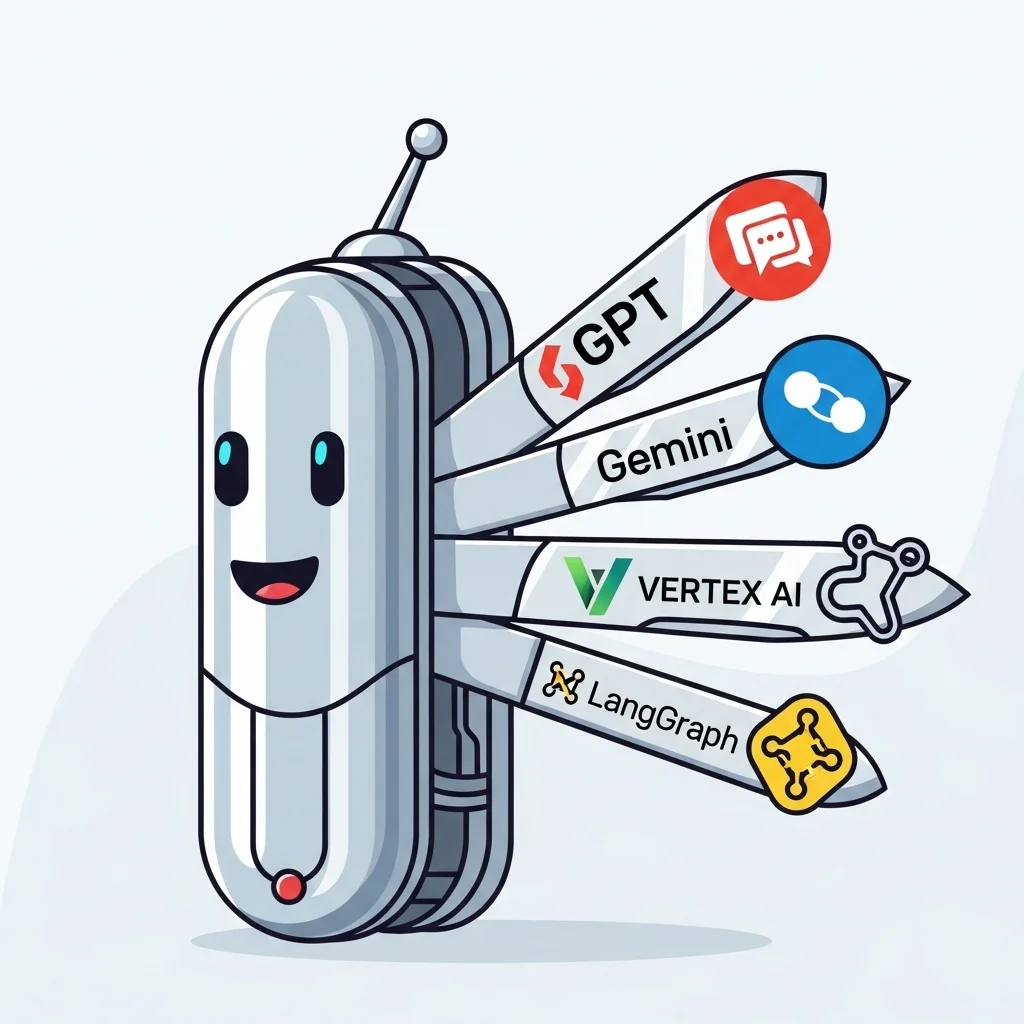

Met Mind orkestreren we diezelfde drie lagen, maar pluggen we ieder gewenst model in (GPT-5, Gemini 2.5, Grok 4, Llama-4 etc.). Zo voorkom je vendor lock-in én profiteer je van de snelste innovaties.

Zo pak je je eerste agent-project aan

Scope scherp

Wat lost de agent op? Begin klein (bijv. e-mail triage) en formuleer één KPI.

Kies je stapel

Heb je streng compliance-regime? Ga dan voor een platform met HIPAA/SOC2 (Vertex, Mind-private). Wil je fine-grained controle? Mind-orchestratie.

Bouw het "Brain"

Prompt-architectuur, systeeminstructies, evaluatie-metrics. Wat wij doen is nested prompting plus een guard-rail-layer in Mind om hallucinaties te vangen.

Koppel Tools

Onze aanpak: eerst een RAG-connector op bedrijfsdata, daarna high-impact API's (CRM, ticketing, ERP).

Itereer in sprints

Test live met een interne pilotgroep, verzamel feedback, verfijn geheugen en decision-loops. Onze ervaring: elke week opleveren > lange "big bang".

Benieuwd hoe jouw organisatie een eigen AI-agent in de lucht brengt? Deel je uitdaging hieronder – ik reageer graag met praktische ideeën uit de praktijk. 🤝

1. Wat is een AI-agent écht?

De mythe ontkracht

Laatst vroeg een klant of een "agent" gewoon ChatGPT met een workflow-builder is. Nee dus. Een workflow voert statische paden uit ("if A, then B"). Een agent observeert, kiest stappen en past die live aan op wat hij ziet. Dat lijkt semantisch, maar in code vertaalt het zich naar:

for step in reasoning_loop:

observation = perceive()

action = plan(observation)

result = act(action)

memory.store(observation, action, result)

Die `reasoning_loop` maakt het verschil. Het model beoordeelt zélf of het doorgaat, afrondt of een andere tool inzet. Daar komt meteen de crux: zonder degelijke orchestratie krijg je stapel-hallucinaties waar niemand op zit te wachten.

Componenten onder de motorkap

Brain: LLM + prompt-/rule-layer (b.v. LangGraph node of Mind-Brain module).

Memory: Vectorstore of SQL-facts; versnelt context en reduceert token-kosten.

Tooling: functions-API, databases, externe services.

Evaluator: Scorecards, human-in-the-loop, regression tests.

Wat mij opvalt in de praktijk? Teams onderschatten "state management". Een agent zonder consistente state lijkt briljant in demo's maar breekt in productie. Daarom bevatten Mind-agents een ingebouwde state-machine met versiebeheer: je ziet exact welk pad de agent nam én waarom.

2. Toolkeuze: open-source of no-code?

Het interessante is dat beide kampen razendsnel bewegen

Laten we wat populaire builders koppelen aan recente updates (week 37, 2025):

Open-source highlights

No-code / Enterprise

Google Vertex Agent Builder: sinds 10 sep HIPAA-ready Agent Engine – welkom healthcare-data!

Copilot Studio Agent Builder: preview wave 1 brengt 1.200+ connectors, plus private tenant-ops.

Valkuil: snelheid ↔ controle

Een CTO vertelde me dat zijn team in een middag een prototype in Google Vertex had, maar drie weken later vastliep op een custom SSO-flow. Wij losten dat op door dezelfde agent-logica naar Mind te migreren en enkel een auth-module bij te steken. Flexibiliteit pays off.

Waar past Mind in dit landschap?

Mind biedt een API-laag boven elk model (pro- of open-source) én boven elke builder. Zie het als Zwitsers zakmes: je begint in OpenAI, maar besluit later naar Gemini wilt, prima, je wisselt de backend-adapter en laat de agent-logica staan. Geen herbouw, geen lock-in.

3. Business-waarde: van inbox zero tot revenue ops

Praktijkcases die wij live hebben

Voorbeeld 1 – Servicedesk triage

Een zorginstelling ontving 2k mails per dag. Onze Mind-agent leest de mail, slaat gevoelige data lokaal op (GDPR-proof) en maakt kant-en-klare reply-drafts in hun ticket-systeem. Resultaat: 65 % tijdsbesparing, tickets binnen 2 uur afgehandeld.

Voorbeeld 2 – Sales intelligence

Een B2B-scale-up gebruikte AI voor lead-scoring, maar de modellen waren te generiek. We bouwden een Mind-wrapper rond hun eigen Llama-4 fine-tune, aangevuld met real-time web-scraping. De agent verrijkt CRM-records en plant automatisch demo-calls. Pipeline-groei: +28 % in 6 weken.

Waarom niet gewoon Zapier + GPT?

Dat werkt prima voor hobby-scripts. Maar zodra je moet:

loggen voor audit,

meerdere LLM-calls ketenen,

context uit proprietary databases trekken,

kom je in het domein van agent-orchestratie. Onze filosofie: snelle waarde (prototype) maar wél architectuur die productie-schalen aankan. Daarom koppelt Mind aan Tailwind/Livewire front-ends, logt in Laravel horizon en draait desgewenst self-hosted.

Wat is het grootste verschil tussen een bot en een agent?

Een bot volgt een lineair script. Een agent beoordeelt continu de context, kiest zelf tools en kan zijn plan aanpassen. Uit onze ervaring voelt dat alsof je een stagiair promotie geeft tot junior medewerker: meer autonomie, maar ook hogere eisen aan governance.

Heb je altijd een vector-database nodig?

Niet per se. Voor stateless taken (bijv. factuur-extractie) volstaat directe context. Maar wil je langdurige projecten (research-assistent) dan is geheugen essentieel. Wij kiezen vaak Postgres + pgvector: open-source, schaalbaar en goed te back-uppen. 😊

Waarom zou ik LangGraph verkiezen boven AutoGen?

LangGraph excelleert in visueel inzicht (graph-viz) en foutafhandeling per node. AutoGen wint als je meerdere agent-rollen laat samenwerken. We mixen ze soms: AutoGen voor ideeën-brainstorm, LangGraph voor deterministische uitvoer.

Is HIPAA-compliance in Vertex genoeg voor zorgdata?

Het dekt de infra-kant, maar je moet nog steeds data-minimalisatie, logging en access-controls borgen. Wij plaatsen een Mind-proxy: vragen gaan erdoorheen, gevoelige velden worden gemaskeerd, audit-logs naar een SIEM. Zo blijft de agent compliant end-to-end.

Hoe test je een agent?

Unit-tests op prompt-helpers, integration-tests met mocked API-calls en "scenario-playbacks" in een sandbox. We voeren daarnaast weekly drift-checks: we replayen 50 productie-tasks met fixed expectations om model-veranderingen te detecteren.

Kan ik agents draaien zonder internet-verbinding?

Ja, met self-hosted Llama-4 of DeepSeek op GPU-servers. Mind mount je interne model via API. Houd rekening met hogere latentie en hardware-kosten, maar je data blijft on-prem. 🔒

Hoe beperk ik hallucinatierisico?

– Retrieval-augmented prompts – Temperature < 0.4 voor kritieke acties – Output-validators (regex, JSON-schema) – Human-in-the-loop fase bij lancering. Uit onze ervaring daalt het error-percentage zo naar < 1 %.

Welke rol speelt Spartner in zo'n project?

Wij helpen bij: use-case-selectie, architectuur, implementatie en doorlopende optimalisatie. Dankzij Mind kunnen we razendsnel schakelen tussen modellen, compliance-eisen en front-end technologie – zonder je in een vendor-hoekje te duwen. 🚀