Large Language Models (LLM's)

Overzicht

Large Language Models (LLM's) zijn een categorie generatieve AI modellen die zijn getraind om natuurlijke taal te begrijpen en te produceren. Zij baseren zich op statistische patronen in grote tekstcorpora en gebruiken neurale netwerkarchitecturen, meestal transformerarchitecturen, om teksten te voorspellen en te genereren op basis van een gegeven invoer. LLM's worden toegepast voor uiteenlopende taken, zoals chatinterfaces, vertaling, samenvatting, codegeneratie, zoekfunctionaliteit en contentcreatie.

Sinds circa 2020 zijn LLM's uitgegroeid tot een kerntechnologie binnen kunstmatige intelligentie. Door schaalvergroting in modelparameters, trainingsdata en rekenkracht, in combinatie met optimalisatietechnieken en instructietraining, hebben LLM's een niveau bereikt waarop ze voor veel tekstgebaseerde taken vergelijkbaar of beter presteren dan klassieke regelgebaseerde of smalle machine learning systemen. Tegelijkertijd brengen zij nieuwe uitdagingen met zich mee op het gebied van betrouwbaarheid, interpretatie, veiligheid en ethiek.

Definitie en basisconcepten

Een large language model is een probabilistisch model dat, gegeven een reeks tokens (woorden, subwoorden of tekens), de kansverdeling voorspelt over het volgende token in de reeks. Door herhaaldelijk het volgende token te voorspellen en aan de context toe te voegen, kan het model coherent lijkende tekst van willekeurige lengte genereren. De term "large" verwijst doorgaans naar de schaal van het model, bijvoorbeeld honderden miljoenen tot honderden miljarden parameters, en zeer grote trainingsdatasets.

Belangrijke begrippen bij LLM's zijn onder meer:

Token: de elementaire eenheid van tekst waarop het model wordt getraind, vaak een subwoordsegment of teken.

Parameters: de gewichten in het neurale netwerk die tijdens training worden geleerd.

Contextvenster: het maximale aantal tokens dat het model in één keer kan verwerken. Moderne modellen hebben contextvensters die kunnen oplopen tot honderdduizenden tokens.

Prompt: de tekstuele invoer die de gebruiker het model geeft, inclusief instructies, voorbeelden en context.

Logits en

softmax: interne representaties waarmee het model kansen toekent aan mogelijke volgende tokens.

Architectuur en werking

Transformerarchitectuur

De meeste hedendaagse LLM's zijn gebaseerd op de transformerarchitectuur. Deze architectuur gebruikt zelf aandacht, ook wel self attention, om relaties tussen tokens in een reeks te modelleren. In plaats van sequentiële verwerking per token, zoals bij eerdere recurrente netwerken, kan een transformer alle tokens in de invoer parallel verwerken en hun onderlinge afhankelijkheden expliciet modelleren.

Self attention werkt door voor elk token drie representaties te berekenen, bekend als queries, keys en values. Door de overeenkomsten tussen queries en keys te berekenen, kan het model bepalen welke andere tokens belangrijk zijn bij het verwerken van een specifiek token. De values worden gewogen op basis van deze overeenkomsten en vervolgens gecombineerd om een nieuwe representatie te vormen. Dit mechanisme wordt in meerdere lagen gestapeld, vaak gecombineerd met feedforward netwerklagen en normalisatietechnieken.

Trainingsproces

Het trainingsproces van een LLM bestaat doorgaans uit twee hoofdfasen. In de eerste fase, pretraining, wordt het model geleerd om het volgende token te voorspellen in een zeer grote tekstcorpus. Dit gebeurt via zelftoezicht, zonder expliciete labels, doordat de tekst zelf de trainingsdoelen levert. De standaard trainingsdoelstelling is een taalmodeldoel, waarbij het model leert om de kans op de juiste vervolgtokens te maximaliseren en de trainingsfout (bijvoorbeeld cross entropy) te minimaliseren.

In de tweede fase, vaak aangeduid als finetuning of instructietraining, wordt het model aangepast voor specifieke taken of gebruiksscenario's. Hierbij wordt het model bijvoorbeeld getraind op vraag antwoordparen, dialoogdata of domeinspecifieke documenten. Moderne LLM's worden vaak verder verfijnd via technieken die menselijk feedback combineren met reinforcement learning of vergelijkbare methoden. Deze technieken zijn bedoeld om de output beter af te stemmen op menselijke voorkeuren, veiligheidseisen en taakrelevantie.

Inference en sampling

Tijdens gebruik, ook wel inference, krijgt het model een prompt als invoer en genereert het één voor één outputtokens. Het model berekent voor elk stap een kansverdeling over alle mogelijke tokens. De daadwerkelijke keuze kan deterministisch zijn, bijvoorbeeld door steeds het meest waarschijnlijke token te kiezen, of stochastisch door sampling.

Bij sampling worden technieken zoals temperatuur, top k sampling en top p sampling gebruikt om een balans te vinden tussen voorspelbaarheid en creativiteit. Lagere temperatuurwaarden en restrictieve samplinginstellingen leveren voorspelbare, maar mogelijk minder creatieve tekst op, terwijl hogere waarden meer variatie en soms onverwachte resultaten opleveren.

Toepassingen

LLM's worden toegepast in een breed spectrum aan domeinen waarin taal of code centraal staat. Veelgebruikte toepassingen zijn onder meer:

Conversatie en chatinterfaces, bijvoorbeeld klantenservice, interne helpdesks of persoonlijke assistenten.

Tekstgeneratie, zoals het schrijven van artikelen, rapporten, productomschrijvingen of marketingteksten.

Samenvatting van documenten, e mails, juridische teksten of onderzoeksartikelen.

Vertaling tussen natuurlijke talen.

Codeassistentie, zoals het genereren, uitleggen of refactoren van programmacode.

Informatieopvraging en zoekfunctionaliteit, vaak gecombineerd met retrievaltechnieken waarbij externe databronnen worden geraadpleegd.

Analyse van sentiment, intentie en entiteiten in tekst.

In veel moderne systemen worden LLM's gecombineerd met aanvullende componenten. Voorbeelden zijn retrieval augmented generation, waarbij het model in real time documenten ophaalt en meeneemt in de context, en toolgebruik, waarbij het model externe functies aanroept, bijvoorbeeld databases, rekenmachines of interne API's. Dit vergroot de actualiteit en precisie van antwoorden, omdat het model niet uitsluitend hoeft te vertrouwen op de kennis die tijdens training in de parameters is opgeslagen.

Modeltypen en voorbeelden

Large language models bestaan in verschillende varianten, afhankelijk van architectuur, doel en licentiemodel. Grofweg zijn er gesloten, commerciële modellen en open source modellen.

Gesloten modellen worden aangeboden als clouddiensten door grote technologiebedrijven en zijn doorgaans niet vrij te downloaden. Zij worden continu geüpdatet en bieden vaak hoge prestaties, brede multimodale mogelijkheden en geïntegreerde veiligheidslagen. Open source modellen worden publiekelijk beschikbaar gesteld, zodat organisaties ze op eigen infrastructuur kunnen draaien en aanpassen. De prestaties van open source modellen zijn de laatste jaren snel verbeterd, waardoor zij voor veel zakelijke toepassingen gelijkwaardig of voldoende zijn.

Naast tekstgebaseerde LLM's zijn er multimodale varianten die naast tekst ook beelden, audio of video kunnen verwerken. Dergelijke modellen kunnen bijvoorbeeld een afbeelding analyseren en beschrijven, of een tekstprompt omzetten in een beeld of videosequentie. De onderliggende principes blijven grotendeels hetzelfde, maar de invoer en interne representaties zijn uitgebreid naar meerdere modaliteiten.

Voordelen

LLM's bieden meerdere voordelen ten opzichte van traditionele benaderingen voor natuurlijke taalverwerking. Een belangrijk voordeel is generalisatie. Door training op zeer diverse data kunnen LLM's taken uitvoeren die niet expliciet zijn geprogrammeerd, maar impliciet zijn geleerd uit de data. Dit maakt zogeheten zero shot en few shot leren mogelijk, waarbij het model met weinig of geen specifieke voorbeelden toch zinvolle output kan genereren.

Daarnaast kunnen LLM's meerdere taken in één model verenigen. Waar vroeger voor elke taak een afzonderlijk model nodig was, zoals voor sentimentanalyse, vertaling of vraag beantwoording, kan een LLM al deze taken combineren op basis van instructies in de prompt. Dit vereenvoudigt architecturen en verkort ontwikkeltijd.

Een ander voordeel is de flexibiliteit in interactie. LLM's ondersteunen natuurlijke taal als interface, waardoor gebruikers technische systemen kunnen aansturen via gewone taalcommando's. Dit verlaagt de drempel voor niet technische gebruikers en maakt complexere workflows toegankelijker.

Beperkingen

Ondanks hun kracht hebben LLM's duidelijke beperkingen. Een fundamentele beperking is dat zij geen expliciet begrip van de wereld hebben, maar werken als probabilistische patroonherkenners. Dit kan leiden tot hallucinaties, situaties waarin het model overtuigend maar onjuist of verzonnen informatie produceert. Hallucinaties zijn problematisch in domeinen waar nauwkeurigheid essentieel is, zoals geneeskunde, recht of financiën.

Een andere beperking is gebrek aan actuele kennis. LLM's worden getraind op data tot een bepaald tijdstip. Zonder integratie met externe databronnen of periodieke hertraining kennen zij ontwikkelingen na dat tijdstip niet of slechts via aanvullende finetuning. Daarom worden LLM's vaak geïntegreerd met zoekmechanismen of kennisbanken om up to date informatie te leveren.

Verder kunnen LLM's bias vertonen, doordat zij leren van tekst die menselijke vooroordelen of scheve representaties bevat. Dit kan zich uiten in stereotyperende of discriminerende output. Onderzoekers en aanbieders proberen dit te mitigeren met datasetcuratie, alignmentprocedures en filters, maar volledige neutraliteit of afwezigheid van bias is in de praktijk moeilijk te garanderen.

Ook zijn LLM's rekenintensief. Zowel training als inference vereisen aanzienlijke hardware, vaak in de vorm van GPU's of andere accelerators. Hoewel optimalisatietechnieken zoals quantization, distillation en model pruning de kosten verlagen, blijft schaalbaarheid een belangrijk aandachtspunt, zeker bij toepassingen met hoge belasting of lage latency eisen.

Veiligheid, ethiek en governance

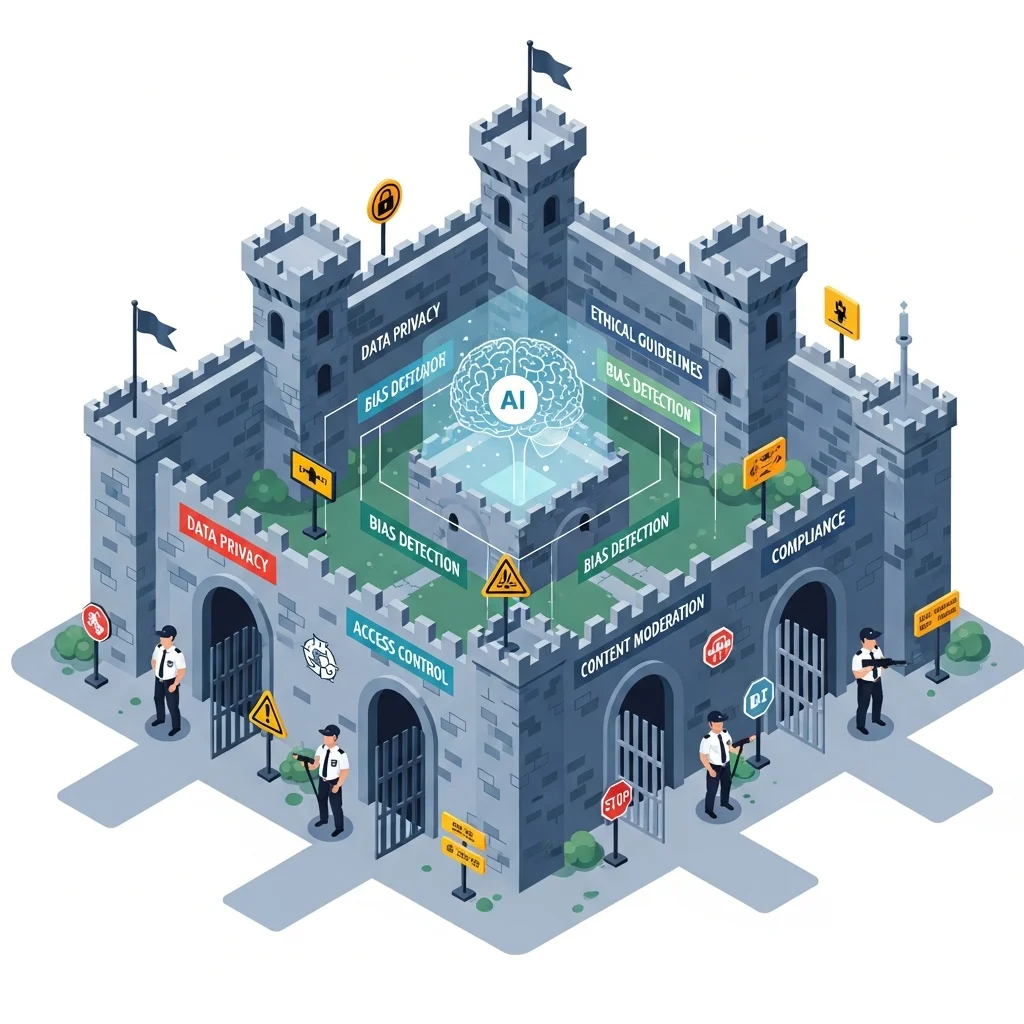

De inzet van LLM's roept belangrijke vragen op over veiligheid, ethiek en governance. Enerzijds kunnen LLM's worden misbruikt voor de productie van misleidende informatie, spam, phishingberichten of geavanceerde social engineering. Daarnaast bestaat het risico dat LLM's ongepaste, schadelijke of illegale content genereren als zij niet adequaat zijn afgeschermd.

Organisaties die LLM's inzetten, implementeren daarom diverse veiligheidslagen. Voorbeelden zijn inhoudsfilters op prompt en output, beleid om bepaalde onderwerpen te beperken, monitoring van gebruikspatronen en technische maatregelen om bijvoorbeeld het genereren van malwarecode of instructies voor illegale activiteiten te blokkeren. Ook worden richtlijnen opgesteld voor verantwoord gebruik, vooral in hoog risico sectoren zoals gezondheidszorg, juridische dienstverlening en kritieke infrastructuur.

Op beleidsniveau zijn er toenemende reguleringsinitiatieven, zoals wettelijke kaders voor AI die transparantie, risicobeoordeling en documentatie vereisen. Voor LLM's betekent dit onder meer aandacht voor uitlegbaarheid, herkomst van trainingsdata, privacy, auteursrecht en mechanismen voor klacht en bezwaar. Governance rond LLM's omvat de inrichting van processen voor beoordeling, goedkeuring, monitoring en incidentrespons.

Technieken voor verbetering en controle

Prompt engineering

Prompt engineering is het systematisch ontwerpen en structureren van invoerprompts om betere modeloutput te krijgen. In plaats van een korte vraag, wordt de prompt aangevuld met context, instructies, voorbeelden en beperkingen. Dit kan de nauwkeurigheid, consistentie en veiligheid van antwoorden verbeteren, zonder het onderliggende model te hoeven wijzigen. Voorbeelden zijn het specificeren van rol en stijl, het expliciet vragen om stap voor stap redenering of het opleggen van formaatregels, bijvoorbeeld voor JSON output.

Retrieval augmented generation

Retrieval augmented generation, vaak afgekort als RAG, combineert een LLM met een zoek of opslagsysteem. Eerst wordt, op basis van de gebruikersvraag, relevante documenten opgehaald uit een database, zoekmachine of vectorstore. Deze documenten worden samengevat en als aanvullende context toegevoegd aan de prompt. Het LLM genereert vervolgens een antwoord dat expliciet naar deze bronnen verwijst. Op deze manier blijft de kennis up to date en wordt het risico op hallucinaties verminderd, mits de onderliggende bronnen betrouwbaar zijn.

Finetuning en adaptertechnieken

Naast basisinstructietraining worden LLM's vaak verder aangepast voor specifieke organisaties of domeinen. Dit kan via volledige finetuning, waarbij alle parameters worden geüpdatet, of via parameter efficiënte methoden zoals LoRA of adapters. Bij deze methoden worden extra lagen of parameterblokken toegevoegd, terwijl het originele model grotendeels bevroren blijft. Dit verlaagt de rekenkosten en maakt het mogelijk om meerdere aangepaste varianten van hetzelfde basissmodel te onderhouden.

Evaluatie en benchmarks

De kwaliteit van LLM's wordt beoordeeld aan de hand van benchmarks en evaluatiesets. Deze sets bevatten taken zoals multiple choice vragen, redeneringsproblemen, vertaling of codeopgaven. Uitkomsten worden gemeten met metriek zoals nauwkeurigheid, F1 score of BLEU score, afhankelijk van het taakspecifieke criterium. Er bestaan generieke benchmarkcollecties die verschillende domeinen en moeilijkheidsgraden omvatten, alsook domeinspecifieke benchmarks voor bijvoorbeeld juridische of medische taal.

Naast kwantitatieve benchmarks worden menselijke evaluaties uitgevoerd. Hierbij beoordelen menselijke beoordelaars de output op criteria zoals juistheid, coherentie, stijl, bruikbaarheid en veiligheid. Menselijke evaluaties zijn arbeidsintensief, maar belangrijk om subtiele kwaliteitsaspecten te meten die moeilijk in numerieke metriek te vangen zijn.

Gebruik in bedrijfsomgevingen

In bedrijfscontexten worden LLM's steeds vaker geïntegreerd in softwarearchitecturen als centrale taallaag. Zij fungeren dan als interpretatiemodule tussen gebruikers, interne systemen en databronnen. Typische scenario's zijn automatisering van klantenservice, ondersteuning van kenniswerkers, genereren van zakelijke documenten en optimalisatie van marketing en communicatie.

Voor productiegebruik in organisaties spelen aanvullende eisen een rol. Dit betreft onder andere gegevensbescherming, logging en audit trail, beheer van modelversies, monitoring van prestaties en latency, en integratie met bestaande identity en access management systemen. Daarnaast wordt vaak een hybride benadering gekozen, waarbij generieke commerciële modellen worden gecombineerd met domeinspecifieke open source modellen of interne finetunes, afhankelijk van de gevoeligheid van de data en de gewenste mate van controle.

Samenvattend vormen large language models een centrale bouwsteen in de huidige generatie AI toepassingen. Zij bieden brede mogelijkheden voor taal en kennisgerelateerde taken, maar vereisen bewuste omgang met hun beperkingen, risico's en governance.