Kunstmatige intelligentie (AI) ontwikkelt zich in een duizelingwekkend tempo. Nieuwe modellen als GPT-5 Turbo, Gemini 2.5 en Claude Sonnet 4.5 komen wekelijks voorbij, en de mogelijkheden lijken grenzeloos. In dit artikel lees je hoe de technologie werkt, welke kansen en risico's er spelen en waar oplettende organisaties vandaag al op sturen.

Heb je je wel eens afgevraagd waarom AI ineens overal opduikt?

Kernpunten

Na jaren van belofte verschuift AI in 2025 van experimenteel naar mainstream. De jongste generatie foundation-modellen, zoals GPT-5 Turbo en Gemini 2.5, produceren foutloze code, meer-talige content en zelfs real-time video. Tegelijk versnellen open source-initiatieven (Llama 4, DeepSeek) het innovatieritme buiten de big tech-reuzen. Bedrijven ontdekken daardoor nieuwe groeipaden én nieuwe risico's.

Actuele inzichten:

- Grootste doorbraak: tokenprijs daalt 40 % in zes maanden

- Realtime multimodale input (spraak, beeld, video) standaard in SaaS-tools

- Wetgeving (AI-Act, GDPR) dwingt tot betere governance

Actionable insight

Begrijp de architectuur van moderne LLM's

Start klein met een use-case binnen marketing of klantenservice

Richt nu al model-governance en data-hygiëne in

De razendsnelle evolutie van AI-modellen

OpenAI presenteerde vorige week GPT-5 Turbo, een model dat tien miljoen tokens context bewaakt zonder merkbare vertraging. Google's Gemini 2.5 counterde meteen met native ondersteuning voor live videostreams. Ondertussen rolt Anthropic Claude Sonnet 4.5 uit, met een latency onder de 200 ms bij 8 k context, terwijl X-ai Grok 4 publiek test op het X-platform. Het resultaat voelt als een wapenwedloop, maar de echte winst zit in praktische verbeteringen: consistentere output, lagere kosten per 1 K tokens en sterkere bescherming tegen prompt-injecties.

Een interessante ontwikkeling: open source loopt sneller in dan ooit. Meta's Llama 4 is getraind op 15 T tokens en scoort in open benchmarks binnen 3 % van GPT-5 Turbo. Dit drukt de drempel om zelf on-premise te draaien, wat vooral risk-averse sectoren prettig vinden.

Zakelijke kansen en risico's in het MKB

De meeste mkb-bedrijven beginnen met generatieve content. Denk aan marketingpagina's via https://spartner.nl/ai-content-maken of geautomatiseerde servicedesk-antwoorden, vergelijkbaar met de use-case op https://spartner.nl/ai-email-servicedesk-ontwikkelen. De winst: 30-50 % lagere doorlooptijd voor copy, plus hogere consistentie in tone-of-voice.

Daarmee komen ook risico's. Onbewuste data-lekken sluipen snel binnen wanneer gevoelige klantdata in prompts belandt. De recente Azure-incidenten (8 okt.) lieten zien hoe legacy deployments op GPT-4 onbedoeld data-retentie aanzetten, met meldingen op de Azure OpenAI statuspage. Governance is dus geen luxe. Moderne middleware, zoals het Mind-platform, plaatst een auditable laag tussen gebruiker en model en voorkomt weglekkende PII.

Technische basis: zo werkt een LLM in 2025

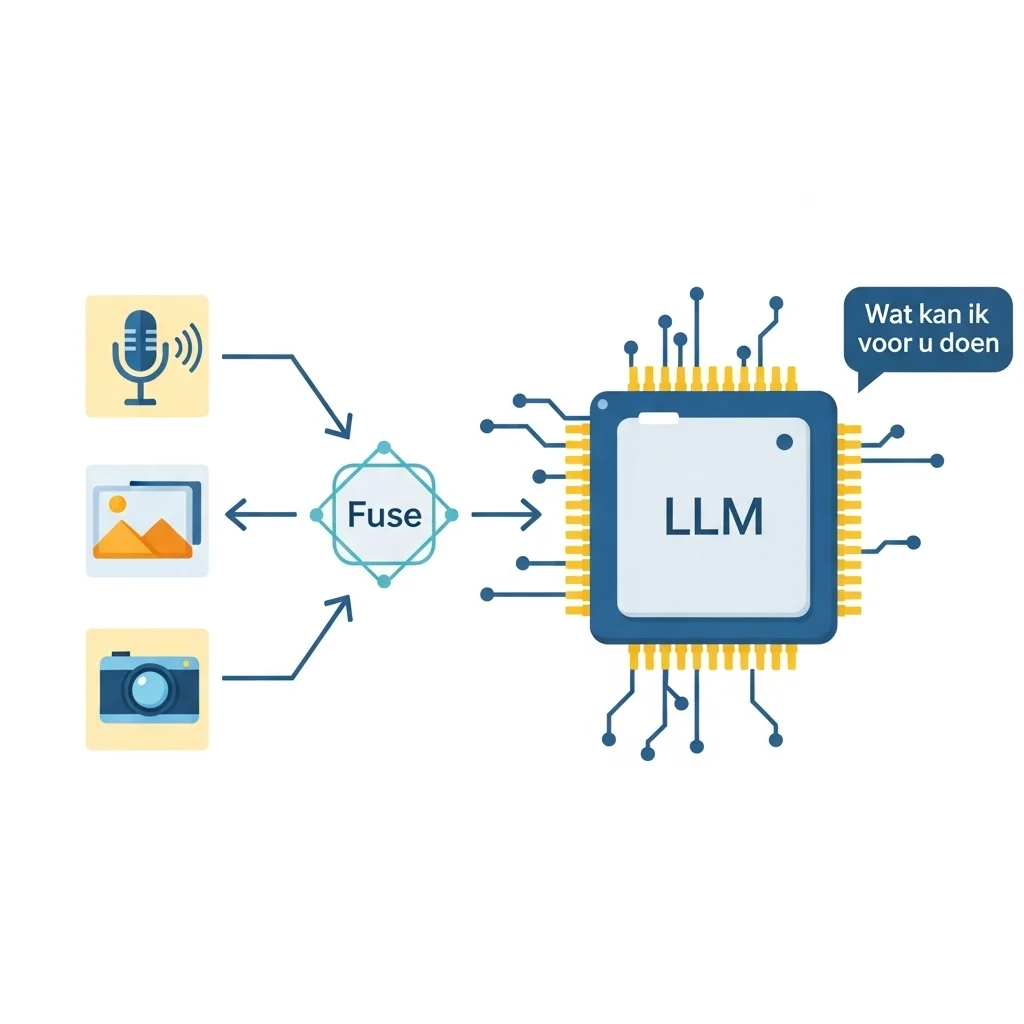

Ter illustratie een vereenvoudigde pseudocode-flow van een multimodale promptpipeline:

def generate_answer(audio, image, text_prompt):

speech_text = WhisperV4().transcribe(audio)

image_caption = GazeV3().describe(image)

fused_prompt = f"{speech_text}\n{image_caption}\n{text_prompt}"

response = GPT5Turbo().chat(

content=fused_prompt,

system="Respond in clear Dutch, cite sources."

)

return response

Pre-processing verschuift naar gespecialiseerde modellen (Whisper V4, Gaze V3).

Het LLM fungeert als orkestrator op bovenliggende semantische laag.

Output wordt post-gefilterd via een policy-engine (bijvoorbeeld OpenAI's Guardrails 2.0).

Governance en ethiek, de volgende uitdaging

Wetgevers bewegen mee. De Europese AI-Act finale tekst wordt in november verwacht en verbiedt 'unrestricted emotion recognition' en 'social scoring'. Organisaties moeten straks risk levels bijhouden en modelupdates documenteren. Een praktische aanpak is het vastleggen van modelversies in een Model Register plus interne DPIA's. Platforms als https://spartner.nl/grip-op-ai-governance tonen hoe bedrijven compliance-maatregelen kunnen inbedden zonder innovatie af te remmen.

Het interessante is dat techniek hiervoor de sleutel aanreikt. Door Retrieval Augmented Generation (RAG) te combineren met regelgebaseerde filters, blijft traceerbaar welke bron een antwoord drijft. Dat geeft auditors houvast én voorkomt hallucinerende statements in bijvoorbeeld juridische contractanalyse.

Wat is het verschil tussen GPT-5 Turbo en Gemini 2.5?

GPT-5 Turbo focust op ultralage latency en een context window van tien miljoen tokens. Gemini 2.5 legt de nadruk op native video- en spraakinput.

Waarom kiezen steeds meer bedrijven voor open source-modellen?

Uit onze ervaring blijkt dat open source LLM's (Llama 4, DeepSeek) voorspelbare kosten en volledige data-controle bieden. Dit is aantrekkelijk voor sectoren waar IP-bescherming kritiek is.

Hoe voorkom je dat gevoelige informatie in de prompt lekt?

Een gangbare praktijk is prompt-pre-sanitizing, gecombineerd met een middlewarelaag die gevoelige entiteiten maskeert. Tools zoals het Mind-platform hanteren standaard PII-filters 🙂

Is een AI-project altijd kostbaar?

Niet per se. Door klein te starten met één gebruiksscenario – bijvoorbeeld automatische blogpostgeneratie via https://spartner.nl/blog-ai-automatisering – blijven initieel budget en risico overzichtelijk.

Hoe snel verouderen modellen?

Modellen vernieuwen gemiddeld elke drie tot zes maanden. Dankzij model-agnostische architectuur kan dezelfde applicatie vandaag met GPT-5 Turbo draaien en morgen met Claude Opus 4.1.

Welke wetgeving is het meest relevant?

De Europese AI-Act voor hoog-risico-toepassingen en natuurlijk GDPR voor alle data-verwerking. Beide vereisen transparantie over modelkeuzes en dataflows.

Kan AI mijn bestaande systemen integreren?

Ja. Via API-koppelingen (REST, GraphQL) of direct database-connectors voegt een agent context toe. Spartner koppelt die integraties vaak met Laravel-gebaseerde back-ends, zodat maatwerk soepel blijft draaien. 🚀

Hoe begin ik met AI zonder alles tegelijk te willen?

Selecteer een pijnpunt met snelle ROI, stel een meetbare KPI en bouw een minimum viable prototype. Optimaliseer daarna iteratief, zodat draagvlak en budget gelijke tred houden.