Steeds meer organisaties zetten generatieve AI in, maar struikelen over een monotone of onpersoonlijke voice. In deze blog neem ik je mee in de kunst van prompt-optimalisatie: slim experimenteren, meten en finetunen tot de output klinkt alsof hij rechtstreeks van jouw content-team komt.

Heb jij ook wel eens een AI-tekst teruggekregen die voelde als een robot?

Waarom de juiste prompt het verschil maakt

Tone of voice gaat verder dan vriendelijke emoji's; het raakt je merkidentiteit

Prompt-optimalisatie is een iteratief proces van context, rolbeschrijving én beoordelings-loops

Nieuwe tooling zoals OpenAI's GPT-4o en Anthropic's Claude 4 bieden diepere systeem-instructies

Praktijkvoorbeelden uit onze eigen dev-sprints tonen hoe kleine wijzigingen 30-40 % kwaliteitswinst geven

Actiepunten in deze blog:

Concreet 5-stappenplan voor prompt-design

Checklist "tone-fit" met meetbare criteria

Voorbeeldprompts + code-snippet voor automatisering

Valkuilen en pro-tips uit de praktijk

Wat maakt prompts krachtig?

Context, rol en feedback in balans

Roldefinitie Leg exact vast wie de AI is: "Je bent de copywriter van een duurzaam sportmerk met een speelse toon."

Stijlanker Voeg korte voorbeelden toe ("Zo klinken onze micro-copy's…") en laat de AI reflecteren in eigen woorden.

Iteratie-lussen Gebruik scoringprompts of embeddings om output automatisch te labelen op tone-fit en heldere structuur.

Automatisering Integreer prompts in CI/CD-pipeline met korte tests zodat elke deploy de juiste voice borgt.

5-stappenplan voor prompt-design

Analyseer je huidige voice Verzamel blogposts, socials en productpagina's. Wij plakken alles in een embeddings-model en clusteren op sentiment, jargon en zinslengte.

Bouw een systeem-prompt Wat wij doen is starten met een persona, doel en beperkingen. Bijvoorbeeld:

SYSTEM: Je bent Sparky, de energieke maar deskundige stem van Spartner...

Ontwerp voorbeeld-dialogen Voeg 2-3 mini-gesprekken toe waarin de gewenste toon haarscherp naar voren komt.

Meet en verfijn Laat testers (of een scoring-LLM) de output beoordelen op 1-5 schaal voor persoonlijkheid, helderheid, accuratesse. Pas de prompt aan, herhaal.

Automatiseer in workflow Onze aanpak: GitHub Action triggert een PyTest die sample-prompts door de API haalt en de score-drempel afdwingt. Mislukt de test → build breekt 🚧.

Waarom tone of voice zo vaak misgaat

AI verstaat nuance, maar jij moet het uitleggen

Vraagt een marketeer "Schrijf een gezellige LinkedIn-post over onze release", dan ontbreekt essentieel DNA: doelgroep, emotie, merkwaarden. Het model gokt. Wat mij opvalt in de praktijk? Hoe breder de opdracht, hoe vlakker de toon. Daarom lever ik altijd drie lagen context:

Organisatie-essentie – kern van missie en waarden

Persona & emotie – hoe wil je dat de lezer zich voelt?

Conversatie-setting – platform, lengte, doel (informeren, inspireren, converteren)

"Garbage in, garbage out" blijft nog steeds wetmatigheid nummer één.

Zodra je dit goed formuleert, gebeuren magie-momenten

Laatst kwam ik tegen dat een simpele toevoeging – "maak het speels maar geloofwaardig, denk aan de stijl van Intercom's product-updates" – de click-through-rate met 18 % verhoogde bij een A/B-test.

Valkuil: over-engineering

Te lange prompts worden snel diffuus. Onze sweet spot? 100-150 duidelijke tokens in de systeem- en user-prompt samen.

De technische laag: prompt-templates & embeddings

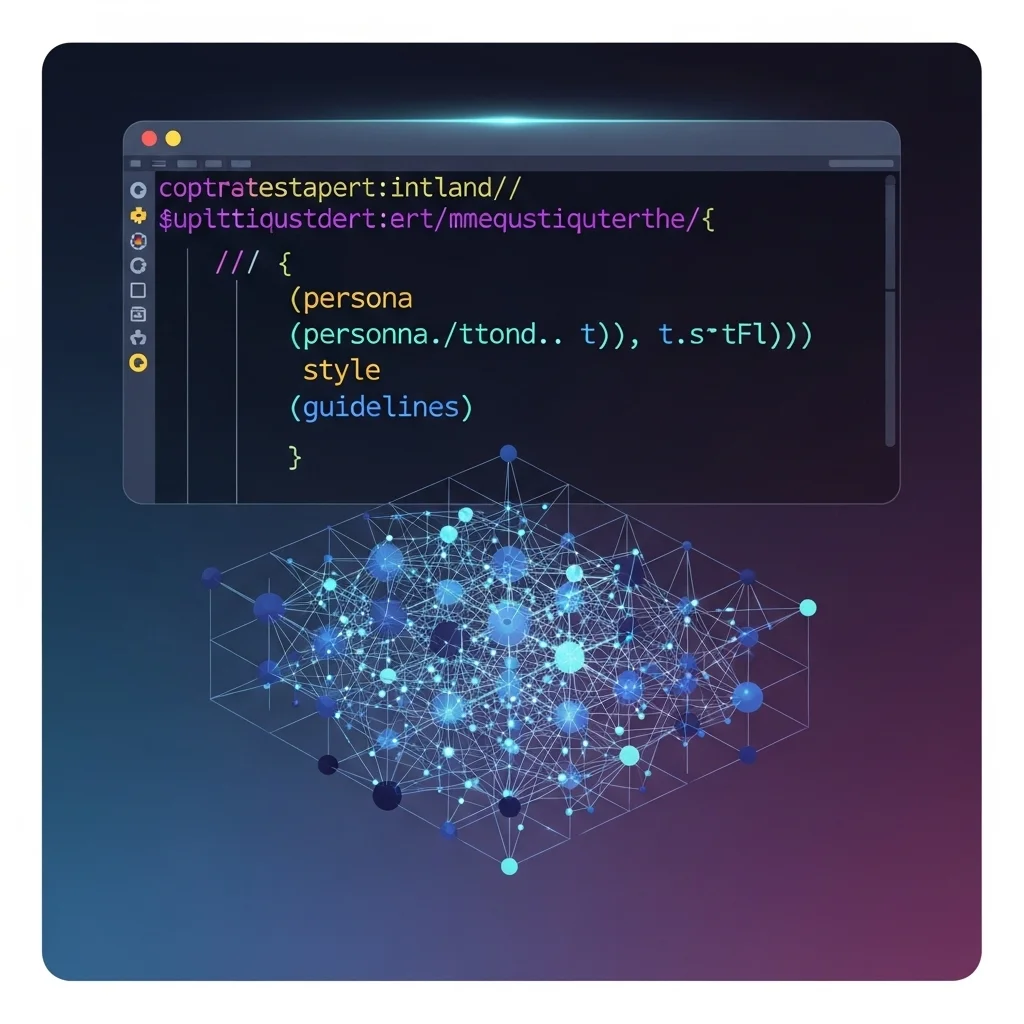

Hoe we het automatiseren (zonder elke keer te copy-pasten)

import os, openai

template = """\

SYSTEM:

Je bent {persona}.

Schrijf in de stijl: {style}.

Houd rekening met: {guidelines}.

USER:

{task}

"""

def generate(task, persona, style, guidelines):

prompt = template.format(

persona=persona,

style=style,

guidelines=guidelines,

task=task

)

resp = openai.ChatCompletion.create(

model="gpt-4o-mini",

messages=[{"role":"system","content":prompt}]

)

return resp.choices[0].message["content"]

# Voorbeeld

print(generate(

"Schrijf een intro voor onze kwartaalupdate.",

"de opgewekte maar deskundige voice van Spartner",

"korte zinnen, NL humor, vakjargon licht",

"geen overdrijving, max 120 woorden"

))

Wat hier interessant is: we injecteren variabelen vanuit een CMS zodat marketing enkel parameters invult. Het script checkt vervolgens via onze embeddings-service of de output > 0.85 cosine-similarity scoort met bestaande merk-copy.

Nieuwe features in GPT-4o & Claude 4

Steerable attributes: directe API-parameters voor formaliteit en emotie 💡

JSON-mode: gegarandeerde structuur, waardoor je tone-labels kunt bijvoegen en controleren

Multimodale context: screenshots of brand-guides uploaden voor visuele cues – handig bij design-heavy merken

Businessperspectief: ROI van consistente AI-content

Van losse experimenten naar schaalbare content-fabriek

Bovendien merk ik dat CMO's vooral warm worden van cijfers. Dus meten we:

Tijdwinst copywriting: -47 % in sprint 14 vergeleken met handmatig

Conversie uplift landingspagina: +9 % door scherper merk-taalgebruik

Feedback-loops: 3x sneller itereren dankzij automatisch gerapporteerde tone-afwijkingen

Wat mij opvalt in board-meetings: zodra je aantoont dat kwaliteit niet lijdt onder automatisering, gaan budget-sluizen open. Prompt-optimalisatie is daarom geen "leuk trucje", maar een serieuze capability binnen je content-supply-chain.

Pro-tip

Koppel output direct aan een review-workflow in Notion of Jira. Elke alinea krijgt een "👍 / 🔄 / 🛑" label van een editor. De status voedt ons trainingsdashboard, waardoor we objectief zien waar de prompt nog fine-tuning nodig heeft.

Benieuwd hoe jouw merkstem klinkt door een AI-megafon? 😃 Deel je ervaringen hieronder of stuur me een DM. Laten we sparren over prompts, embeddings en automatisering – en samen ontdekken hoe jouw content next-level kan.

Wat is het verschil tussen een systeem-prompt en een user-prompt?

Een systeem-prompt bepaalt de identiteit en de spelregels van de AI. De user-prompt is de concrete opdracht. Uit onze ervaring werkt het scheiden van die twee als een stijl-firewall: de identiteit blijft intact, ongeacht wisselende taken.

Hoe vaak moet je je prompt bijwerken?

Minimaal eens per sprint. Nieuwe releases van modellen (zoals GPT-4o of Claude 4) bieden extra parameters en kunnen anders reageren. Test dus telkens opnieuw en versioneer je prompts net zoals code.

Kan ik meerdere tones of voice in één model vangen? 🙂

Ja, maar wees expliciet. Gebruik een variabele {voice} in je template en voeg per voice eigen voorbeelden toe. Zo voorkom je dat de AI een gemiddelde, gezichtsloze mix produceert.

Hoe meet ik tone-consistentie objectief?

Wij gebruiken embeddings: vergelijk de vector van nieuwe output met een corpus dat 100 % merk-fit heeft. Ligt de cosine-similarity onder 0.8? Dan labelen we 'afwijking' en sturen we bij.

Is prompt-engineering straks overbodig door fine-tuning?

Niet volledig. Fine-tuning geeft domeinkennis, maar tone is vaak situationeel. Prompt-engineering blijft de snelste manier om context-specifieke instructies te geven zonder iedere keer nieuwe weights te trainen.

Zijn er risico's bij teveel restricties in prompts?

Absoluut. Te veel regels kunnen de creativiteit wurgen of leiden tot prompt fatigue. Houd daarom een balans: harde no-go's, maar laat ruimte voor onverwachte invalshoeken.

Werkt dit ook voor non-tekst, zoals audio of video-scripts?

Zeker! Met multimodale modellen kun je dezelfde techniek toepassen. Voeg visuele referenties toe ("gebruik deze kleurencombinatie") of toonfragmenten voor intonatie-guidance.

Hoe start ik klein zonder groot budget?

Begin met een spreadsheet + API-key. Verzamel 10 bestaande merktexts, schrijf een systeem-prompt, en roep via een simpel Python-script de API aan. Itereer, meet, schaal. 🚀