De anatomie van zelflerende systemen

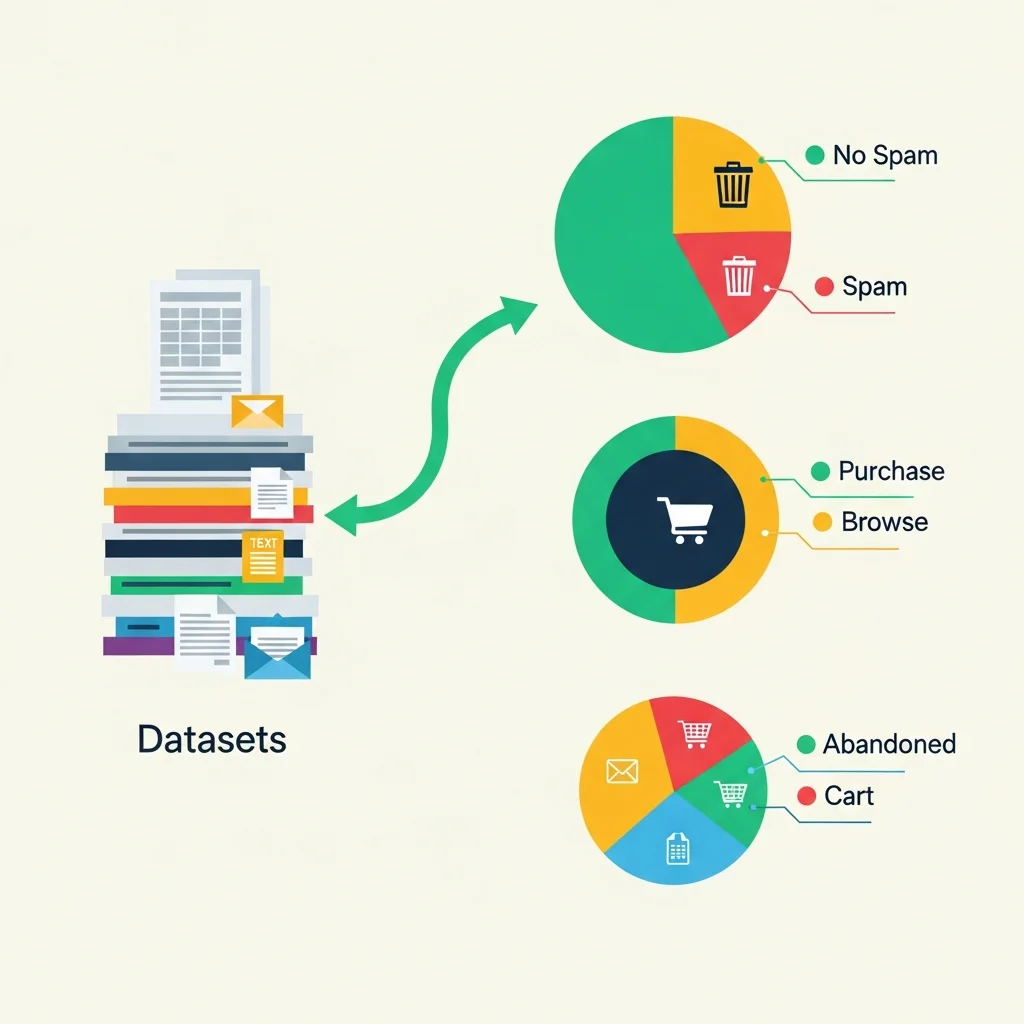

Machine learning (ML) is de wetenschap van het laten handelen van computers zonder expliciet geprogrammeerd te zijn. Waar traditionele algoritmen een vaste reeks stappen volgen, bouwen ML-algoritmen een wiskundig model gebaseerd op voorbeelddata ("trainingsdata") om voorspellingen of beslissingen te maken zonder expliciet geprogrammeerd te zijn om die specifieke taak uit te voeren.

Kernconcepten in detail

Om machine learning echt te begrijpen, moeten we kijken naar de fundamentele bouwstenen:

1. Features en Labels

Data is de brandstof. We onderscheiden "features" (de inputvariabelen, bijv. pixels van een foto of woorden in een zin) en "labels" (de gewenste output, bijv. "kat" of "positief sentiment"). Het proces van het selecteren en transformeren van variabelen om modellen effectiever te maken noemen we feature engineering.

2. Parameters vs. Hyperparameters

Dit onderscheid is cruciaal voor data scientists. Parameters zijn de configuratievariabelen die intern zijn aan het model en waarvan de waarde kan worden geschat vanuit data (bijv. de gewichten in een neuraal netwerk). Hyperparameters zijn instellingen die extern zijn aan het model en waarvan de waarde niet kan worden geschat vanuit data (bijv. de "learning rate" of het aantal lagen in een netwerk). Deze worden vooraf ingesteld door de data scientist.

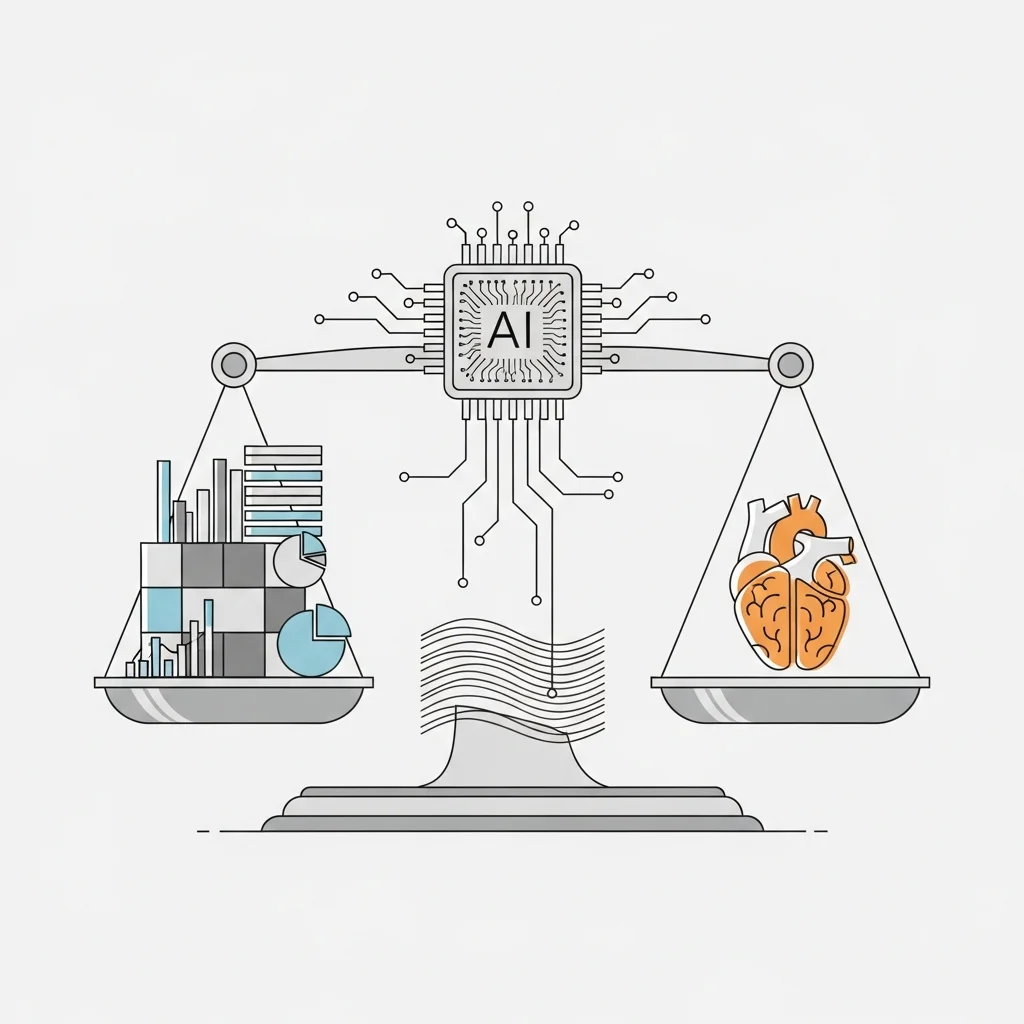

3. De balans: Overfitting en Underfitting

De heilige graal van ML is generalisatie: het vermogen om correct te presteren op nieuwe, ongeziene data.

Overfitting: Het model leert de trainingsdata te goed, inclusief de ruis en toevalligheden, en faalt in de echte wereld.

Underfitting: Het model is te simpel om de onderliggende structuur van de data te vangen.

Algoritmen en Architecturen

Er bestaat geen "one size fits all" algoritme. De keuze hangt af van de aard van de data en het probleem.

Klassieke methoden

Voor gestructureerde data (tabellen) zijn klassieke algoritmen vaak nog steeds superieur in efficiëntie en uitlegbaarheid. Denk aan Lineaire Regressie voor het voorspellen van getallen, of Decision Trees en Random Forests voor classificatievraagstukken.

Neurale Netwerken en Deep Learning

Voor ongestructureerde data zoals beeld, geluid en tekst zijn neurale netwerken de standaard geworden. Deze zijn geïnspireerd op biologische neuronen en bestaan uit lagen van knooppunten die signalen doorgeven. Deep Learning verwijst naar netwerken met vele ("diepe") lagen, die in staat zijn om extreem abstracte patronen te herkennen.

Evaluatie en Metrics

Hoe weten we of een model goed is? Dat hangt af van de metriek:

Accuracy: Het percentage juiste voorspellingen. (Pas op: bedrieglijk bij ongebalanceerde data!)

Precision & Recall: Belangrijk bij zeldzame events (zoals fraudedetectie).

F1-Score: Het harmonisch gemiddelde van precision en recall.

De toekomst: Foundation Models

We zien een verschuiving van taak-specifieke modellen naar "Foundation Models" (zoals LLM's). Deze enorme modellen zijn getraind op brede data en kunnen met weinig of geen extra training ("zero-shot" of "few-shot learning") worden aangepast voor talloze specifieke taken. Dit verlaagt de drempel voor het toepassen van geavanceerde AI aanzienlijk.

Wil je dieper ingaan op de technische implementatie van machine learning in je IT-landschap? Spartner helpt organisaties met robuuste, schaalbare AI-architecturen.